„Information ist das Öl des 21. Jahrhunderts, und Analytik ist der Verbrennungsmotor“ – Peter Sondergaard, ehemaliger Senior Vice President bei Gartner

In einer Welt, die immer stärker digital vernetzt ist, gibt es ein enormes Potenzial, personalisierte Daten zu nutzen, um Modalitäten in verschiedenen Bereichen zu optimieren. Die Auswirkungen des Big-Data-Trends sind in nahezu jeder Branche zu sehen, einschließlich des Medien- und Verlagssektors. Es werden neue Technologien entwickelt, um den Prozess der Datenanalyse zu automatisieren und zu optimieren. Heerscharen von Datenanalysten werden ausgebildet und eingestellt, um die stetig steigende Nachfrage nach der Analyse dieser Daten zu decken.

Für Zeitungen, Fernsehsender, Magazine und reine Online-Verlage können Big-Data-Strategien Audience Analytics umfassen, um Kunden besser zu verstehen und gezielter anzusprechen. Es gibt Tools, um öffentliche und private Datenbanken für journalistisches Storytelling zu verstehen. Außerdem gibt es Tools zur Verwaltung und Durchsuchung der Fülle an Videos, sozialen Medien und anderen Inhalten. Tools sind auch verfügbar, um die Produktion von Text- und Videogeschichten zu automatisieren. Und vieles mehr!

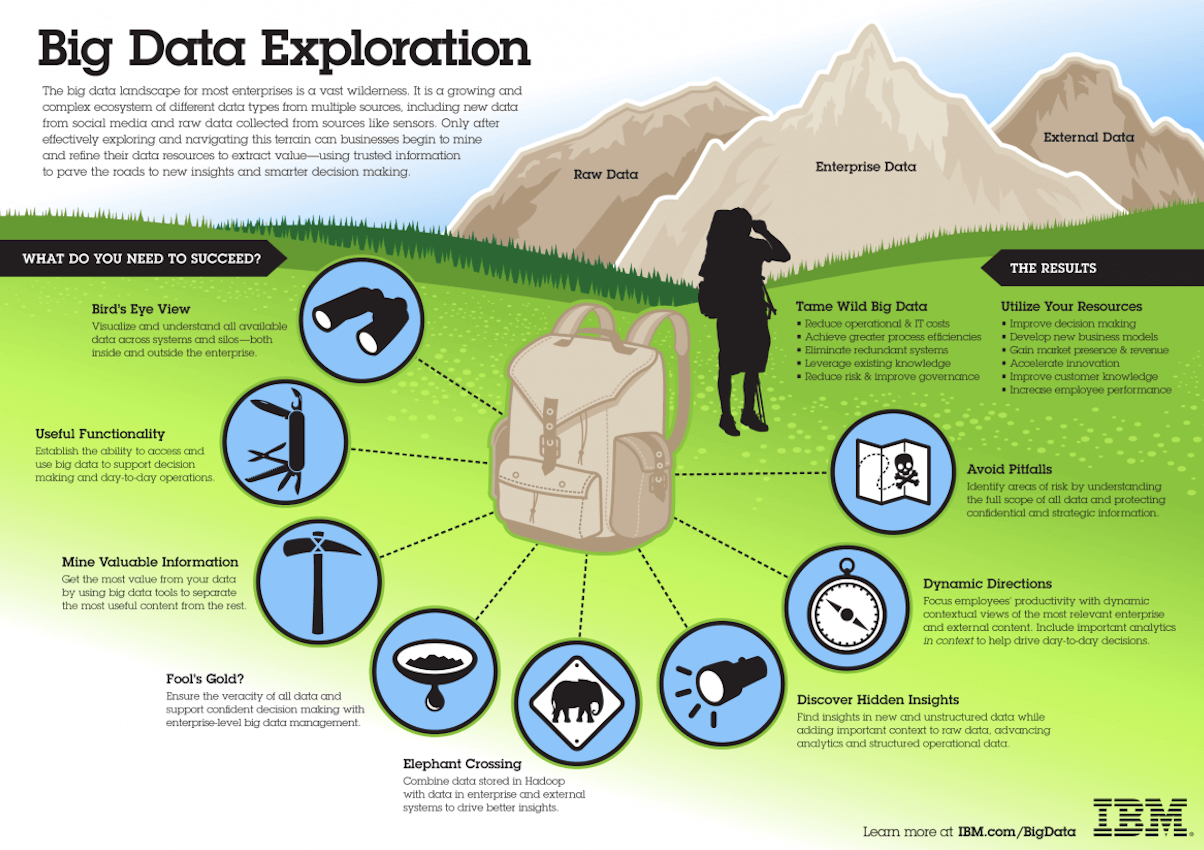

Moment mal! Was ist Big Data eigentlich?

Gartner definiert Big Data als „hochvolumige, hochfrequente und/oder vielfältige Informationsbestände, die kosteneffiziente, innovative Formen der Informationsverarbeitung erfordern, die verbesserte Einblicke, Entscheidungsfindung und Prozessautomatisierung ermöglichen“.

„Big Data bezieht sich auf hochvolumige, hochfrequente und/oder vielfältige Informationsbestände, die kosteneffiziente, innovative Formen der Informationsverarbeitung erfordern, die verbesserte Einblicke, Entscheidungsfindung und Prozessautomatisierung ermöglichen.“

Das Konzept gewann in den frühen 2000er Jahren an Fahrt, als der Branchenanalyst Doug Laney die drei Vs von Big Data formulierte:

- Volume (Volumen): Bei Big Data müssen Sie voluminöse Mengen an datenarmen, unstrukturierten Daten verarbeiten.

- Velocity (Geschwindigkeit): Dies ist die hohe Geschwindigkeit, mit der Daten empfangen und möglicherweise verarbeitet werden.

- Variety (Vielfalt): Dies bezieht sich auf die verschiedenen verfügbaren Datentypen wie strukturierte, unstrukturierte und semistrukturierte Daten.

In den letzten Jahren sind zwei weitere Vs aufgetaucht: Value (Wert) und Veracity (Wahrhaftigkeit). Daten haben einen intrinsischen Wert, sind aber nutzlos, bis dieser Wert entdeckt wird. Ebenso wichtig ist es zu wissen, wie wahrheitsgemäß Ihre Daten sind und wie sehr Sie sich auf sie verlassen können.

Heute ist Big Data zu Kapital geworden. Denken Sie nur an einige der größten Technologieunternehmen der Welt. Ein großer Teil des von ihnen gebotenen Werts stammt aus ihren Daten, die sie ständig bewerten und analysieren, um mehr Effizienz zu erzielen und neue Produkte zu entwickeln.

Big Data für Medien- und Verlagsunternehmen

Medien- und Verlagsunternehmen sammeln minütlich Unmengen von Daten aus verschiedenen Bereichen ihrer Organisationen. Diese Bereiche können Werbung/Vertrieb, Inhalte, Konten, Leserschaft/Nutzerschaft/Mitgliedschaft und mehr sein. Sie produzieren auch Datenbestände in Form von Videos, Bildern, Texten und Grafiken.

Medien- und Verlagsunternehmen sammeln minütlich Unmengen von Daten aus verschiedenen Bereichen ihrer Organisationen.

Die Big-Data-Konferenzen haben einige wertvolle Erkenntnisse für Medien- und Verlagsunternehmen mit Ambitionen, Big-Data-Strategien einzusetzen, hervorgebracht. Hier ist, was einige der Unternehmen, die von Big Data profitiert haben, auf diesen Konferenzen zu sagen hatten.

Die Geschichte von HuffPost

Das Nachrichtenportal HuffingtonPost.com hatte 2014 22 Millionen monatliche Besucher auf 11 globalen Ausgaben, und 16 weitere Ausgaben sollten bis Ende 2015 geplant werden. Jimmy Maymann, der damalige CEO von HuffPost, folgte dem Mantra: „Es dreht sich alles um die Daten“. HuffPost nutzte Big Data, um Inhalte zu optimieren, Kommentare zu authentifizieren, die Effizienz nativer Werbung sicherzustellen, Anzeigenplatzierungen zu regulieren und passive Personalisierung aufzubauen.

Inhaltsoptimierung

Maymann sagte, dass Big Data einen präziseren analytischen Ansatz zur Entscheidungsfindung ermöglicht, um das Nutzer- und Werbetreibenden-Erlebnis zu verbessern. Ein Echtzeit-Statistik-Dashboard und eine Analyseplattform treiben den gesamten redaktionellen Prozess von HuffPost an, erklärte er.

Zum Beispiel testeten die Redakteure von HuffPost den positiven Einfluss von Überschriften auf die Leserschaft mittels A/B-Tests. Maymann schrieb den A/B-Tests einen deutlich höheren Traffic auf Artikeln zu. Er betonte auch die Bedeutung, Inhalte zur richtigen Zeit, auf dem richtigen Gerät und der richtigen Zielgruppe bereitzustellen.

Durch die Bewertung von Big Data im Eltern-Bereich konnten sie feststellen, welche Eltern, die Inhalte typischerweise auf ihren Mobilgeräten statt auf ihren Desktops abrufen, an Wochentagabenden online aktiv sind. Um diese Zielgruppe zu erreichen, veröffentlichten sie Inhalte, wenn Eltern online waren, was den Traffic auf Artikeln, die für Eltern von Interesse waren, ankurbelte, so Maymann. Einer der Eltern-Blogs von HuffPost, „10 Ways Living with a Toddler is Like Being in Prison“, erhielt in 7 Stunden 24.000 Aufrufe, und fast 41 % der Aufrufe stammten aus Social-Media-Verweisen.

Kommentar-Authentifizierung

Die Inhalte von HuffPost erhielten 2013 300 Millionen Leserkommentare. Maymann nutzte Big-Data-Analysen, um zu verstehen, wie das Nutzererlebnis durch die Authentifizierung von Leserkommentaren verbessert werden kann. HuffPost führte eine Conjoint-Analyse durch, eine statistische Technik, die verwendet wird, um zu bestimmen, wie Nutzer die in einem Produkt oder einer Dienstleistung verfügbaren Funktionen und Merkmale bewerten.

Die Conjoint-Analyse half dabei, festzustellen, ob die Qualität der Kommentare von unbekannten Personen oder von solchen, die sich mit Namen oder Avatar identifiziert haben und von einem bestimmten Ort stammen. Die Analyse zeigte, dass die Qualität der Kommentare besser war, wenn sie von Personen stammten, die den Befragten regional näher waren und sich nicht als unbekannt auswiesen.

Die Ergebnisse veranlassten HuffPost, die Registrierung für Kommentatoren einzuführen und anonyme Beiträge zu unterbinden, sagte Maymann. „Wir werden die „Basher“ los und haben jetzt eine höhere Qualität der Kommentare, auch wenn wir in der Presse dafür kritisiert wurden [anonyme Kommentare zu beenden]“, sagte Maymann.

Durch den Einsatz von Big-Data-Analysen konnte HuffPost feststellen, dass die native Werbung der Website eine höhere Markenbekanntheit als gesponserte Inhalte erzielte. Auch im Vergleich zu Standardmedien wurde eine höhere Markenbekanntheit erreicht.

Werbetreibende bei der Einhaltung von Vorschriften unterstützen

HuffPost nutzte Big Data, um mögliche Verstöße gegen die Nähe zwischen Pharmaanzeigen und verwandten redaktionellen Inhalten zu kennzeichnen. Die Wortsuchfunktion identifizierte sensible Wörter, die gegen die Pharmavorschriften verstießen, und löste so die Blockierung von Anzeigen in der Nähe des Inhalts aus, sagte Maymann.

Passive Personalisierung

HuffPost nutzte eine Technologie eines der neuesten Assets ihres Mutterkonzerns, um individuelle Nutzerinteressen über das Surfverhalten zu identifizieren. Dies half dabei, die richtigen Inhalte durch passive Personalisierung mit den richtigen Personen zu verbinden. Maymann erklärte: „Interessengraphen werden aus Algorithmen abgeleitet, die interessenbezogene Nutzerdaten identifizieren. Dies ist eine Momentaufnahme aller Interessen, an denen alle Besucher interessiert sind; man kann sehen, wie viel, abhängig von der Größe der Kreise. Was treibt das Engagement auf Websites an? Das sagt uns, worauf wir uns konzentrieren sollten.“

Die Geschichte der Financial Times

Daten waren maßgeblich für die Financial Times. Sie schreibt die Erfassung von Registrierungsdaten, die über ihre Paywall mit Zähler erfolgte, als Verdienst zu. Die gesammelten Daten ermöglichten es der FT, den Kunden besser zu bedienen, gezielte Werbekampagnen zu erstellen und neue Produkte auf der Grundlage von Daten zu Hintergrund und Interessengebieten ihrer Leser zu entwickeln.

„Vor fünf oder sechs Jahren haben wir ein neues Medienmodell eingeführt, bei dem der Zugang über ein Zählsystem berechnet wird. Als wir damit anfingen, ging es primär darum, einen Online-Umsatzstrom aufzubauen, aber was im Laufe der Zeit wahrscheinlich wichtiger war, waren die Daten und Kundeneinblicke, die uns das verschaffte. Das hat das Geschäft transformiert“, sagte CEO John Ridding laut einem Mashable-Artikel vom April 2014.

Tom Betts, Chief Data Officer, sagte, dass sich die Nachrichtenkonsummuster verschieben und nun die Abonnements für FT.com die Abonnements der FT-Zeitung übertreffen. Die Datenerfassung hat dazu beigetragen, digitale Abonnements zu steigern, indem ein besseres Kundenverständnis genutzt wurde. Mit den gesammelten Daten erstellte die FT Profile des digitalen Konsums ihrer Leser. Dies half dabei:

- Kundenpräferenzen für Inhalte verstehen

- Die Relevanz der FT-Kommunikation an Kunden erhöhen

- Inhalte personalisieren

- Intelligenz an Kundenkontaktpunkten einsetzen

Daten haben einen intrinsischen Wert, sind aber nutzlos, bis dieser Wert entdeckt wird.

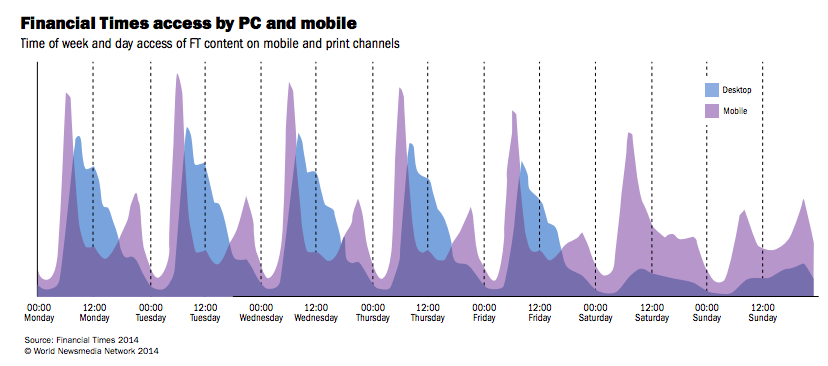

Die Hinzunahme mobiler Kanäle, bestehend aus Tablet- und Smartphone-Plattformen, trug zu einer erhöhten Komplexität beim Verständnis jedes FT-Kunden bei. Zum Beispiel könnten Inhalte an Wochenenden auf Smartphones und Tablets konsumiert werden, während management- oder finanzbezogene Inhalte an Wochentagen im Büro auf dem Desktop konsumiert werden könnten.

„Eine Multichannel-Ansicht gibt uns einen einzigartigen Kontext über Kundenbedürfnisse und -verhalten“, sagte Betts. Die Profile sind hilfreich, um Personas zu erstellen, für die neue FT-Produkte entwickelt werden können, zum Beispiel eine Führungskraft im Einzelhandel mit viel verfügbarem Einkommen für Luxus und Reisen. Oder ein junger mittlerer Manager mit hohen Zielen, in den Rängen aufzusteigen.

„In diese Segmentierung ist Engagement eingebettet, nicht nur die Ansprache der wahrscheinlichsten Abonnenten“, sagte Betts. „[Die Segmentierung] hilft uns bei der Produktentwicklung.“

„Welche Implikationen ergeben sich für eine Tageszeitung mit 126 Jahren Geschichte? Das bringt Arbeitsweisen und Prozesse mit sich. Wir müssen jetzt die Gegebenheiten betrachten und uns weiterentwickeln. Sollten wir abends veröffentlichen [um den Anforderungen der Leser gerecht zu werden]?“ sagte Betts. „Es gibt eine Diskrepanz zwischen dem Zeitpunkt der Veröffentlichung und dem Zeitpunkt des Konsums. Wir müssen mehr wie ein Sender mit einer Programmiermentalität denken. Wir müssen optimieren, um diesen Anforderungen gerecht zu werden.“

Für Medienunternehmen, die eine Big-Data-Strategie beginnen, hat Betts einen Ratschlag:

- Nutzen Sie einen kundenorientierten Ansatz, um Ihre Daten zum Leben zu erwecken

- Seien Sie besessen von der Datenerfassung

- Seien Sie nicht dogmatisch bei der Datennutzung und den Tools

- Brechen Sie aus, räumen Sie Missverständnisse aus und legen Sie los!

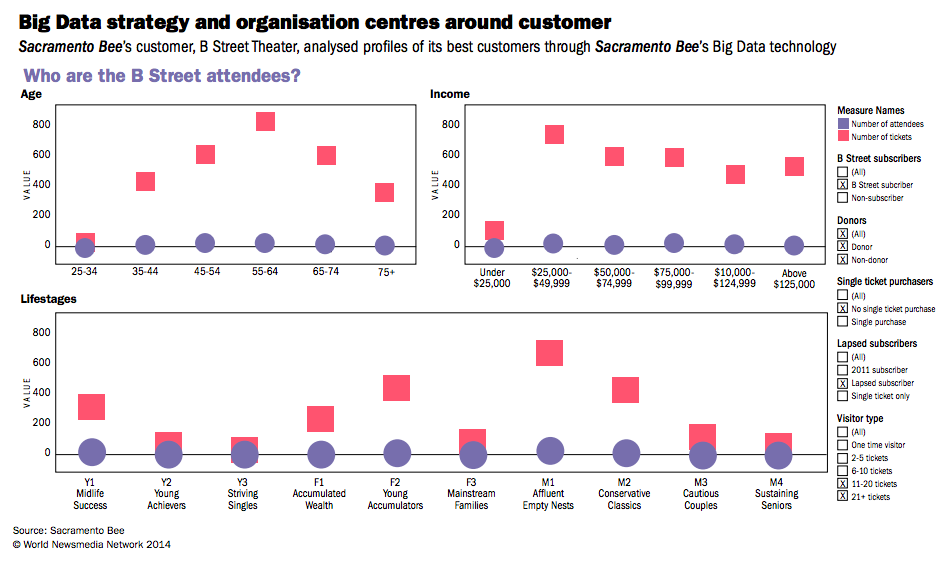

Die Geschichte der Sacramento Bee

Die Sacramento Bee verfolgte einen systematischen Ansatz für ihre Big-Data-Strategie. Mit dem Ziel, sich für die Zukunft zu positionieren, stellte sich das amerikanische Zeitungsunternehmen den Big-Data-Herausforderungen aus folgenden Perspektiven:

- Technologische Systeme

- Kundenanalyse und -verfolgung

- Geschäftsmodelle

- Kulturelle Aspekte

Jeder dieser Bereiche zeigte taktische Herausforderungen auf, wie Datenvisualisierungen von Zielgruppen- und Finanzdaten. Es präsentierte auch unternehmensweite Themen wie das individuelle Content-Profiling-System des Unternehmens, das darauf abzielt, mehr über Online-Besucher zu erfahren.

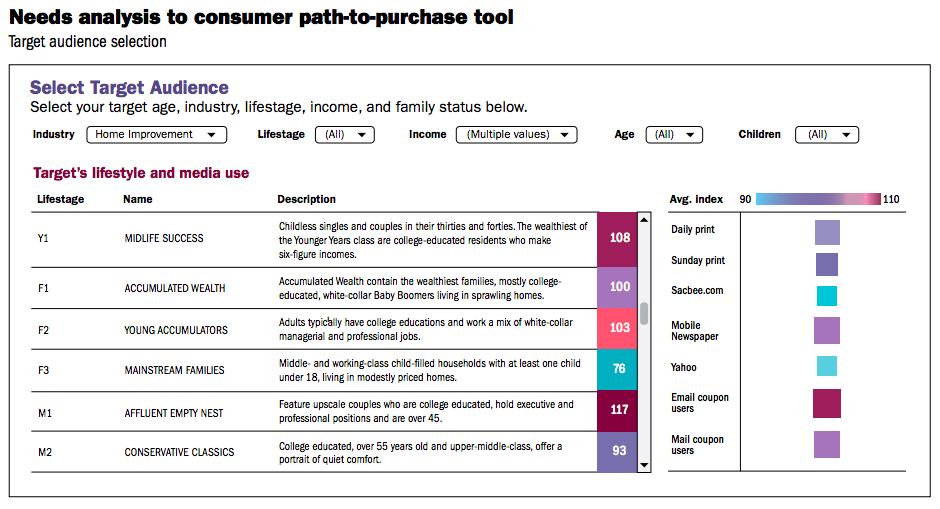

Darrell Kunken, Forschungsdirektor, bemerkte: „Es dreht sich alles um unsere Inhalte“. Kunken sagte, es seien Anstrengungen unternommen worden, um Bereiche zu identifizieren, die von Daten betroffen sind, und die Tools anzuwenden, um die Daten zu visualisieren und nutzbar zu machen. Zu den Bereichen, in denen Datenvisualisierungstaktiken eingesetzt wurden, gehörten Autohändlerverkäufe, kleine und mittelständische Kunden, Einkaufstrends und Path-to-Purchase-Daten für Werbeverkaufsunterlagen.

Die Bee kartierte, wo aktuelle und ehemalige Abonnenten leben, und nutzte Corporate Performance Management (CPM)-Berichterstattung für unterstützende Materialien der Geschäftsverwaltung. Audience Analytics half der Nachrichtenabteilung zu verstehen, wie lange Leser mit Geschichten interagierten.

Die Bee nutzte die Datenvisualisierungstechnologie namens Tableau, um Daten für Autohändler auf dem Sacramento-Markt zu visualisieren. Dies half ihnen zu zeigen, wie sie im Vergleich zu Wettbewerbern bei Fahrzeugverkäufen abschnitten.

Big Data hat der Bee ermöglicht, ein ausgeklügeltes Path-to-Purchase-Visualisierungstool zu entwickeln, um Werbetreibenden zu helfen, demografische und spezielle Interessengruppen anzusprechen. Es arbeitete mit den Daten lokaler Unternehmen und bewertete diese, um den Eigentümern ihre besten Kunden, deren demografische Aufschlüsselung und ihre geografischen Standorte zu zeigen.

Fazit

Wohin steuern wir also mit so vielen Daten? Gibt es eine Zukunft, in der wir uns so stark auf Daten verlassen, wo viele Scheinkorrelationen unseren Lebensstil und unsere Existenz dominieren? Big-Data-Technologie ist unerlässlich, um tiefere Einblicke zu gewinnen und Daten besser zu verstehen. Der Journalismus kann stark von der Integration von Big-Data-Strategien profitieren und so den Workflow von Medien- und Verlagsunternehmen optimieren.

Wir bei Opensense Labs sind stets bestrebt, Ihrer Organisation ein ganzheitliches digitales Erlebnis zu bieten, das sich als wegweisend für Ihr Unternehmen erweist. Kontaktieren Sie uns unter [email protected] und lassen Sie uns wissen, wie wir Ihnen helfen können, Big-Data-Strategien in Ihren Geschäftsprozess zu integrieren.

Abonnieren

Verwandte Blogs

E-Commerce und Datenanalyse: Steigern Sie Ihren Umsatz

Möchten Sie eine höhere Kapitalrendite erzielen und gleichzeitig ein tieferes Verständnis für E-Commerce und Datenanalyse…

Customer Data Platform – Ein umfassender Leitfaden

Es wird oft gesagt, dass der Kunde König ist. Haben Sie sich jemals gefragt, warum? Ein Kunde, Konsument, Klient oder…

CDP und Datenschutz für Verbraucherdaten

"Ständige Datenschutzverletzungen und Skandale haben die Customer Data Platform (CDP) in Verbindung mit dem Business…