GenAI vs LLM: Was ist der wahre Unterschied?

AI-TranslatedIn den letzten Jahren hat künstliche Intelligenz enorm an Popularität gewonnen, insbesondere in den sozialen Medien. Stellen Sie sich vor: Sie surfen auf Reddit, scrollen durch Reels auf Instagram, sehen sich Beiträge auf X (ehemals Twitter) an oder unterhalten sich mit Kolleg:innen, und Begriffe wie „GenAI vs. LLM“ und „maschinelles Lernen“ tauchen immer wieder auf.

Sie stimmen der Diskussion zu, aber tief im Inneren fragen Sie sich vielleicht – was bedeuten diese Worte wirklich?

Und warum hat man das Gefühl, dass alle entweder begeistert oder besorgt darüber sind?

Folglich scheinen viele Menschen diese „KI-Begriffe“ austauschbar zu verwenden, als ob sie alle dasselbe Konzept bedeuten würden.

Doch was bedeuten diese Begriffe wirklich, und in welcher Beziehung stehen sie zueinander?

Im Kontext von GenAI vs. LLM umfasst generative KI verschiedene Arten kreativer KI, wie Text, Bilder und Musik. Im Gegensatz dazu konzentrieren sich LLMs speziell auf Sprache. Das bedeutet, dass zwar jedes LLM eine Form generativer KI ist, aber nicht jede Art generativer KI in die Kategorie der LLMs fällt.

Zum Beispiel wird GPT-4o sowohl als großes Sprachmodell (LLM) als auch als generatives KI-Modell (GenAI) anerkannt. Umgekehrt wird Midjourney, das ausschließlich Bilder erstellt, lediglich als GenAI-Modell klassifiziert.

In diesem Blog werden wir uns mit den Grundlagen von GenAI vs. LLM befassen und erörtern, was sie sind, wie sie funktionieren, wann man sie jeweils einsetzt und welche praktischen Beispiele sie voneinander unterscheiden.

Und wenn Sie auf der Suche nach verantwortungsvollen KI-Diensten wie KI-gesteuerter Suche und Personalisierung sind, sehen Sie sich die Angebote für verantwortungsvolle KI von OpenSense Labs an, bevor Sie fortfahren.

Beginnen wir nun mit den Grundlagen!

GenAI vs. LLM: Die Grundlagen verstehen

Die erste wichtige Erkenntnis zu GenAI vs. LLM ist, dass sie weder Gegensätze noch Synonyme sind und auch keine strengen Untergruppen voneinander. Sie repräsentieren verschiedene Arten von KI-Modellen, die sich aus unterschiedlichen Forschungsrichtungen entwickelt haben.

Lassen Sie uns nun die Unterschiede zwischen GenAI und LLM detaillierter betrachten.

Große Sprachmodelle (LLMs) sind fortschrittliche Deep-Learning-Systeme, die auf Transformer-basierten neuronalen Netzen basieren. Sie werden auf großen Textdatensätzen trainiert, die aus Büchern, Websites, Foren und anderen schriftlichen Materialien gesammelt wurden. Modelle wie GPT-4o sind darauf ausgelegt, Sprachmuster und die Verbindungen zwischen Wörtern zu verstehen, wodurch sie in der Lage sind, klare und kontextuell relevante Antworten zu generieren.

Durch dieses Training erlangen LLMs die Fähigkeit, Fragen zu verstehen, Informationen zusammenzufassen, Sprachen zu übersetzen und komplexe Denkaufgaben eigenständig zu lösen.

Der Trainingsprozess legt den Schwerpunkt auf das Erfassen der Verbindungen zwischen Wörtern, die in numerische Formen, sogenannte Embeddings, umgewandelt werden. Zum Beispiel nutzt GPT-4 mehr als eine Billion Parameter und wendet Selbstaufmerksamkeits-Techniken an, um Präzision und kontextuelles Verständnis zu verbessern.

Andererseits repräsentiert generative KI (GenAI) eine breitere Palette von KI-Modellen, die neue Inhalte generieren können, indem sie Muster in ihren Trainingsdaten erkennen und daraus lernen. Anstatt nur Ergebnisse vorherzusagen, erstellt GenAI neue Ausgaben basierend auf den Mustern, die es aufgenommen hat, wodurch es in der Lage ist, Texte, Bilder, Audio und Videos zu produzieren, die von Menschen erstellten Inhalten sehr ähnlich sind.

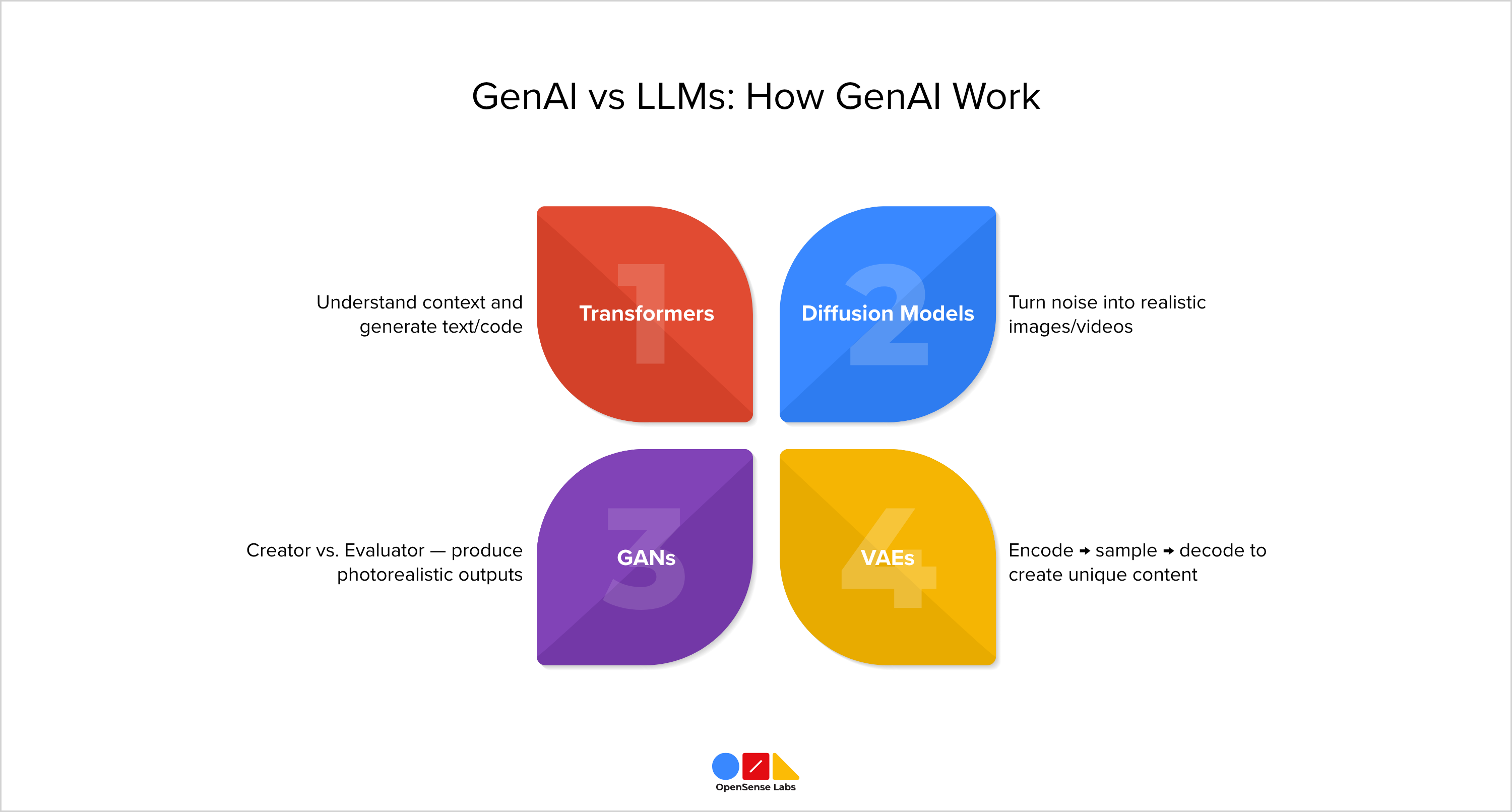

Während sich LLMs innerhalb der GenAI auf Text konzentrieren, sind andere Modelle, wie Diffusion, GANs und VAEs, für die Erstellung von Bildern, Videos und Audio zuständig. Verschiedene Architekturen treiben generative KI an.

Große Sprachmodelle sind ein Beispiel; sie generieren Originaltext mithilfe von Transformer-Architekturen und werden somit als eine bestimmte Art von GenAI klassifiziert. In Bereichen außerhalb des Textes sind jedoch andere Architekturen tendenziell effizienter.

Eines der am häufigsten verwendeten Modelle ist das Generative Adversarial Network (GAN). Dieses Framework besteht aus zwei gegensätzlichen Netzwerken: einem Generator, der Inhalte erstellt, und einem Diskriminator, der die Authentizität dieser Inhalte bewertet. Das Ziel des Generators ist es, Ausgaben zu produzieren, die der Diskriminator nicht von echten Daten unterscheiden kann, wodurch der Unterschied zwischen von Menschen erstellten und von Maschinen generierten Inhalten verringert wird.

Diese Architektur hat zahlreiche Fortschritte in der GenAI ermöglicht, insbesondere in den Bereichen Bild- und Videogenerierung, was zu Innovationen wie Deepfakes, Bildverbesserung und kreativen Design-Tools geführt hat.

Lesen Sie auch

- Verwandeln Sie Ihre Website mit dem Drupal KI-Modul im Jahr 2025

- Ethischer KI-Chatbot: Implementierung des RAIL-Frameworks bei OSL

- Agentische KI-Dynamik: Zukunft der Datenabfrage

- Erklärbare KI-Tools: SHAPs Stärke in der KI

GenAI vs. LLM: Wie GenAI funktioniert

Im Kern der generativen KI stehen Modelle, die darauf ausgelegt sind, Datenstrukturen zu verstehen und Ausgaben zu produzieren, die menschlicher Kreativität ähneln. Diese Technologie treibt Anwendungen wie ChatGPT, DALL·E, Sora und RunwayML an und verändert grundlegend unsere Methoden der Kreativität, Automatisierung und Problemlösung. So funktioniert GenAI:

Transformer

Transformer sind fortschrittliche Deep-Learning-Modelle, die einen Selbstaufmerksamkeitsmechanismus nutzen, um Kontext und Beziehungen in Daten zu erfassen. Sie treiben moderne große Sprachmodelle (LLMs) wie GPT (OpenAI), Claude (Anthropic) und LLaMA (Meta) an und zeichnen sich durch verschiedene Aufgaben aus, darunter Textgenerierung, Übersetzung, Zusammenfassung, Codegenerierung und die Erstellung von Embeddings.

So funktioniert es:

- Wörter in numerische Vektoren umwandeln: Wörter werden zunächst in numerische Vektoren umgewandelt, damit das Modell ihre Bedeutung und Position interpretieren kann.

- Alle Wörter gleichzeitig analysieren: Transformer betrachten alle Wörter zusammen statt einzeln. Zum Beispiel versteht das Modell im Satz „Die Katze jagte die Maus, weil sie hungrig war“, dass „sie“ die Katze bedeutet.

- Die wichtigsten Wörter bestimmen: Der Selbstaufmerksamkeitsmechanismus weist Wörtern Wichtigkeitswerte zu, was dem Modell hilft zu entscheiden, welches für das Verständnis oder die Generierung einer Antwort am wichtigsten ist.

- Informationen durch mehrere Schichten übertragen: Informationen durchlaufen mehrere Schichten, wobei jede das Verständnis des Modells für Bedeutung und Kontext verfeinert.

- Inkrementelle Ausgabe erzeugen: Wenn das Modell Text erstellt, generiert es ein Wort nach dem anderen und verwendet alle bereits produzierten Wörter, um das nächste auszuwählen. Dies stellt sicher, dass die Ausgabe kohärent und kontextrelevant ist.

Diffusionsmodelle

Diffusionsmodelle sind eine Art generativer KI, die Bilder, Videos und Audio erstellt, indem sie zufälliges Rauschen schrittweise in realistische Inhalte umwandelt. Sie lernen, den Rauschprozess Schritt für Schritt umzukehren und Details zu verbessern, um lebensechte Ergebnisse zu erzielen. Einige bekannte Beispiele sind DALL·E 2, Imagen, Stable Diffusion und Sora, die für Aufgaben wie Bildgenerierung, Inpainting und Bild-zu-Bild-Übersetzung verwendet werden.

So funktionieren Diffusionsmodelle:

- Mit authentischen Bildern beginnen: Das Modell lernt, indem es echten Bildern zufälliges Rauschen hinzufügt, bis sie völlig statisch werden, was hilft zu verstehen, wie klare Bilder zu Rauschen werden.

- Die Umkehrtechnik meistern: Als Nächstes wird es darauf trainiert, das Gegenteil zu tun, nämlich Rauschen methodisch zu entfernen. Durch die Praxis vieler Beispiele lernt man, klare Bilder aus ihren verrauschten Versionen wiederherzustellen.

- Aus zufälligem Rauschen erstellen: Beim Erstellen neuer Inhalte beginnt das Modell mit zufälligem Rauschen, ohne ein Referenzbild zu benötigen, und beginnt von Grund auf zu imaginieren.

- Schrittweise Entrauschung: In vielen Phasen verfeinert es das Bild, verwandelt Statik in Formen, dann Texturen und schließlich detaillierte Visualisierungen, ähnlich wie man ein Foto langsam in einer Dunkelkammer entstehen sieht.

Generative Adversarial Networks

Generative Adversarial Networks (GANs) sind KI-Systeme, die entwickelt wurden, um lebensechte Bilder zu generieren. Sie umfassen zwei neuronale Netze: einen Generator, der Inhalte erstellt, und einen Diskriminator, der diese bewertet, wobei beide miteinander konkurrieren. Diese Rivalität ermöglicht es dem Modell, beeindruckend realistische Ergebnisse zu erzielen.

So funktionieren GANs:

- Ein GAN besteht aus zwei neuronalen Netzen: einem für den Erzeuger und einem für den Bewerter. Stellen Sie es sich wie einen Künstler gegen einen Detektiv vor; der Künstler erstellt Fälschungen, während der Detektiv versucht, sie zu finden.

- Der Erzeuger beginnt mit Zufallswerten (Rauschen) und versucht, diese in lebensechte Bilder umzuwandeln. Zuerst sind die Ergebnisse chaotische Kleckse, aber er lernt und verbessert sich allmählich.

- Der Bewerter vergleicht echte Bilder mit generierten, um zu sehen, ob sie echt sind. Während der Erzeuger seine Fähigkeiten verbessert, fällt es dem Bewerter schwerer, Fälschungen zu erkennen.

- Durch Rivalität wachsen der Erzeuger und der Bewerter, wobei der Erzeuger den Realismus verbessert und der Bewerter sein Urteilsvermögen schärft.

- Am Ende wird der Erzeuger so geschickt, dass seine Ergebnisse genau wie echte Bilder aussehen. Zu diesem Zeitpunkt kann der Erzeuger von Anfang an fotorealistische Inhalte selbst erstellen.

Variationale Autoencoder

Variationale Autoencoder (VAEs) sind generative KI-Modelle, die lernen, Daten in einen kompakten latenten Raum zu kodieren und sie dann zu dekodieren, um neue Inhalte zu generieren. Sie werden für die Bild- und Spracherzeugung, Datenkompression und die Erforschung latenter Repräsentationen eingesetzt. Wichtige Beispiele sind VQ-VAE und Beta-VAE.

So funktioniert es:

- Eingabekodierung: Der VAE nimmt ein Bild auf und komprimiert es mithilfe eines Encoders in eine kompaktere Form.

- Eine Möglichkeitswolke erstellen: Anstatt nur eines Vektors erzeugt es eine Verteilung, eine „Wolke“ von Werten, die kontrollierte Zufälligkeit für mehr Flexibilität hinzufügt.

- Aus der Wolke sampeln: Ein Punkt wird zufällig aus dieser Verteilung ausgewählt und an den Decoder gesendet, was dem Modell hilft, zu verallgemeinern.

- Dekodierung und Rekonstruktion: Der Decoder rekonstruiert das Originalbild aus dem gesampelten Code und lernt, vage Ideen in klare Ergebnisse umzuwandeln.

- Neue Inhalte generieren: Nach dem Training erzeugt das Sampling aus dem latenten Raum völlig neue Bilder, die den Originaldaten ähneln, aber dennoch einzigartig sind.

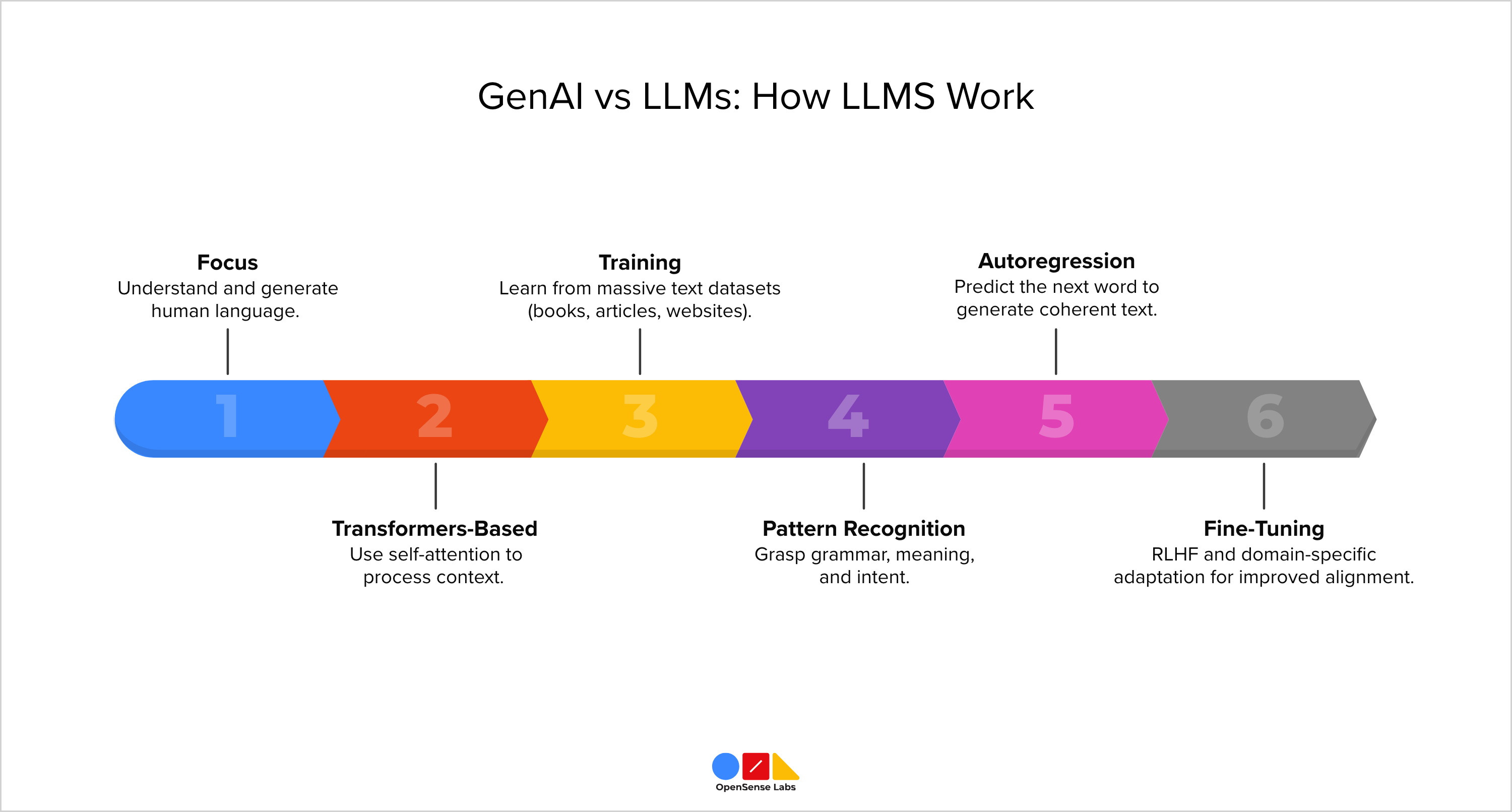

GenAI vs. LLM: Wie LLMs funktionieren

Während GenAI jede Art von Inhalt generieren kann, konzentrieren sich LLMs ausschließlich auf das Sprachverständnis und die Sprachgenerierung.

Große Sprachmodelle (LLMs) sind fortschrittliche KI-Systeme, die darauf ausgelegt sind, Text zu verstehen und zu generieren, der menschliches Schreiben nachahmt. Sie basieren hauptsächlich auf Transformer-Architekturen und treiben Anwendungen wie GPT (OpenAI), Claude (Anthropic), Gemini (Google) und LLaMA (Meta) an. Ihre Stärke liegt in der Verarbeitung großer Mengen von Textdaten, um Aufgaben wie Schreiben, Zusammenfassen, Übersetzen und Schlussfolgern zu erfüllen.

Ähnlich wie Transformer nutzen LLMs Selbstaufmerksamkeit, um Kontext zu verarbeiten, konzentrieren sich aber ausschließlich auf das Verstehen und Produzieren menschlicher Sprache.

So funktionieren LLMs:

- Datenerfassung und Tokenisierung: Große Sprachmodelle (LLMs) werden anhand umfangreicher Textdatensätze trainiert, die aus Büchern, Artikeln, Websites und Foren gesammelt wurden. Dieser Text wird in kleinere Teile, sogenannte Tokens (die Wörter oder Subwörter sein können), zerlegt, die das Modell numerisch verarbeiten kann.

- Sprachmuster verstehen: Während des Trainings lernt das Modell, wie Wörter miteinander in Beziehung stehen, einschließlich Kontext, Grammatik, Bedeutung und Absicht. Mithilfe von Selbstaufmerksamkeit bestimmt es, welche Wörter für das korrekte Verständnis oder die Vorhersage des nächsten Wortes wichtig sind.

- Wissensakkumulation durch Parameter: Jede Verbindung und jedes gelernte Muster wird als Parameter gespeichert. Je größer das Modell (wie GPT-4 mit mehr als einer Billion Parametern), desto tiefer wachsen sein Verständnis und seine Denkfähigkeiten.

- Den nächsten Token antizipieren: Beim Erstellen von Text prognostiziert das Modell den nächsten Token basierend auf allen vorhergehenden, Wort für Wort, um Kohärenz und Kontext zu wahren. Diese Technik, bekannt als Autoregression, ermöglicht es ihm, vollständige, bedeutungsvolle Sätze zu konstruieren.

- Feinabstimmung und fortlaufende Anpassung: Nach dem Vortraining werden LLMs mithilfe von Reinforcement Learning from Human Feedback (RLHF) feinabgestimmt, um die Ausrichtung zu verbessern, und anschließend für bestimmte Bereiche wie Codierung oder Gesundheitswesen angepasst.

Generative KI und LLMs in Ihren Workflow integrieren

Wenn Sie an diesem Punkt sind, haben Sie ein gutes Verständnis für KI entwickelt. Nun fragen Sie sich vielleicht, wie Sie KI effektiv in Ihre Arbeit oder Ihren Alltag integrieren können.

Hier sind einige umsetzbare Schritte für den Anfang:

- Fesselnde Inhalte erstellen: Plattformen wie ChatGPT oder Claude können Ihnen helfen, Ideen zu sammeln, Blogs zu entwerfen oder Gedanken zu skizzieren. Tools wie Obsidian oder Pieces-Plugins bewahren den langfristigen Kontext während des Schreibens.

- Entwicklertools intelligent nutzen: Tools zur Codegenerierung, wie GitHub Copilot und Pieces, arbeiten mit VS Code oder Chrome zusammen, um Ihren Workflow zu beschleunigen.

- Effizient Visuals generieren: Tools wie DALL·E, Midjourney und Canva ermöglichen es Ihnen, Bilder für Präsentationen oder Social-Media-Beiträge zu erstellen oder zu verbessern.

- Interaktive Chatbots erstellen: APIs von OpenAI oder Anthropic ermöglichen es Ihnen, KI-Assistenten in Apps oder Websites einzubetten.

Hoffentlich fühlen Sie sich nun inspiriert, KI in Ihren Workflow zu integrieren. Tatsächlich gibt es für alles, wobei Sie Hilfe in Bezug auf KI benötigen, wahrscheinlich eine Lösung (und wenn nicht, können Sie sie immer selbst erstellen).

Erfolgreiche Beispiele für GenAI- und LLM-Anwendungen

Generative KI-Tools können vielfältige Medien, Videos, Bilder und Audio erstellen, während sich LLMs auf Text spezialisieren, was sie ideal für Chatbots, Assistenten und Schreibwerkzeuge macht.

Je nach Projektanforderungen können Sie sie separat nutzen oder ihre Vorteile für breitere Anwendungen zusammenführen.

Bevor wir fortfahren: Wenn Sie zuverlässige KI-Dienste wie KI-gesteuerte Einblicke und Integration wünschen, sehen Sie sich die verantwortungsvollen KI-Optionen von OpenSense Labs an.

Fahren wir nun mit unserem Verständnis fort!

GenAI vs. LLM: Warum scheitern Multi-Agenten-LLM-Systeme?

Doch während sich LLMs zu Multi-Agenten-Systemen entwickeln, stehen sie vor neuen Herausforderungen in Bezug auf Koordination und Zuverlässigkeit.

Die MAST-Taxonomie wurde durch die manuelle Annotation von über 200 Ausführungsspuren erstellt, wobei jede Spur durchschnittlich über 15.000 Tokens umfasste.

Diese Methode identifizierte 14 Arten von Fehlern in drei Hauptkategorien:

- Spezifikationsprobleme (41,8 %): Schlechte Prompt-Gestaltung, fehlende Einschränkungen oder schwache Abbruchkriterien.

- Fehlausrichtung zwischen Agenten (36,9 %): Missverständnisse, unterschiedliche Überzeugungen oder mangelnder Kontext.

- Fehler bei der Aufgabenüberprüfung (21,3 %): Unzureichende Validierung oder voreilige Schlussfolgerungen.

Diese sich überschneidenden Probleme unterstreichen die Notwendigkeit strukturierter Diagnosen anstelle von Ad-hoc-Inspektionen.

Lesen Sie auch

- UX Best Practices für Website-Integrationen

- Gin Admin Theme: Claro im Drupal CMS ersetzen

- SDC: Storybook & Single Directory Component integrieren

- Erstellen und Integrieren: CKEditor 5 Plugin in Drupal 11

Wichtige Erkenntnisse

- GenAI vs. LLMs: LLMs sind eine Untergruppe der GenAI, die sich auf Text konzentriert, während GenAI ein breiteres Spektrum abdeckt und Bilder, Videos, Audio und mehr generiert.

- LLMs sind fortschrittliche Deep-Learning-Systeme, die Transformer-basierte neuronale Netze nutzen und auf riesigen Textdatensätzen trainiert werden.

- Während sich LLMs zu Multi-Agenten-Systemen entwickeln, zeigt die MAST-Taxonomie 14 Fehlermodi in Design, Ausrichtung und Verifizierung auf, was die Notwendigkeit strukturierter Diagnosen gegenüber Ad-hoc-Korrekturen unterstreicht.

- Generative KI (GenAI) ist eine Art von KI, die neue Inhalte produzieren kann, indem sie Muster in den Daten, mit denen sie trainiert wurde, identifiziert und daraus lernt.

- GenAI treibt ChatGPT, DALL·E, Sora und RunwayML an und transformiert unsere Herangehensweise an Kreativität, Automatisierung und Problemlösung.

Abonnieren

Verwandte Blogs

Ethischer KI-Chatbot: Implementierung des RAIL-Frameworks bei OSL

Im heutigen digitalen Zeitalter transformieren ethische KI-Chatbots Branchen, vom Kundenservice über das Gesundheitswesen…

Agentic AI Dynamics: Die Zukunft der Datenabfrage

In einer Welt, in der die Datenmengen stetig wachsen, kann es sich anfühlen, wie die Suche nach der Nadel im Heuhaufen, die…