KI-Fairness: Ein tiefer Einblick in Microsofts Fairlearn Toolkit

AI-TranslatedKünstliche Intelligenz (KI) hat branchenübergreifend, insbesondere im Finanzdienstleistungssektor, das Spiel verändert. Von der Automatisierung von Kredit-Risikobewertungen bis zur Straffung von Kreditgenehmigungen hat KI eine unglaubliche Effizienz gebracht. Doch mit großer Macht kommt große Verantwortung – und KI-Fairness ist eine der größten Verantwortlichkeiten, denen sich KI-Entwickler stellen müssen. Das Whitepaper von Microsoft und EY zum Fairlearn-Toolkit geht diesem Thema eingehend auf den Grund und bietet praktische Tools und Einblicke, um Verzerrungen in Kreditmodellen entgegenzuwirken.

Und wenn Sie verantwortungsvolle KI-Dienste wie KI-gesteuerte Suche und Personalisierung wünschen, werfen Sie einen Blick auf die verantwortungsvollen KI-Dienste von OpenSense Labs, bevor Sie fortfahren.

KI-Fairness: Das Dilemma der KI-Fairness

Stellen Sie sich vor, Sie beantragen einen Kredit und werden abgelehnt.

Es fühlt sich unfair an, aber was, wenn die Entscheidung von einem voreingenommenen Algorithmus getroffen wurde?

Das ist der Kern des Problems.

Finanzdienstleister verlassen sich auf prädiktive Modelle wie die Ausfallwahrscheinlichkeit (PD), um die Kreditwürdigkeit zu beurteilen. Diese Modelle können jedoch unbeabsichtigt gesellschaftliche Verzerrungen reproduzieren, die in historischen Daten eingebettet sind.

Ein PD-Modell könnte beispielsweise männliche Antragsteller häufiger ablehnen, selbst wenn sie kreditwürdig sind, oder weibliche Antragstellerinnen zu höheren Raten genehmigen, sie aber mit Rückzahlungen kämpfen lassen. Diese Muster offenbaren systemische Ungerechtigkeit, die Tools wie Fairlearn beheben sollen.

Die historischen Wurzeln solcher Verzerrungen reichen über Algorithmen hinaus. Menschliche Entscheidungsfindung leidet seit langem unter impliziten Vorurteilen. Im Kreditwesen gab es beispielsweise jahrzehntelang rassische oder geschlechtsspezifische Ungleichheiten bei Kreditgenehmigungen. Während KI eine Chance bietet, Entscheidungen zu standardisieren, birgt sie auch das Risiko, diese Verzerrungen fortzuschreiben, es sei denn, KI-Fairness wird zu einem zentralen Designprinzip.

Lesen Sie auch:

1. AIOps: Künstliche Intelligenz im DevOps-Einsatz

2. Unternehmen verändern mit Künstlicher Intelligenz und Drupal

3. Top Drupal-Module 2018 mit Künstlicher Intelligenz

4. Digitale Marketingtrends: KI vs. menschliche Texter

KI-Fairness: Das Fairlearn-Toolkit

Fairlearn ist ein Open-Source-Python-Toolkit, das entwickelt wurde, um fairnessbezogene Schäden in KI-Systemen zu bewerten und zu mindern. Es konzentriert sich auf Gruppenfairness – um sicherzustellen, dass Ergebnisse bestimmte Gruppen basierend auf sensiblen Attributen wie Geschlecht, Alter oder Rasse nicht unverhältnismäßig schaden oder bevorzugen. Hier ist ein genauerer Blick auf seine Kernkomponenten:

1. KI-Fairness-Metriken

Fairlearn bietet eine Reihe von KI-Fairness-Metriken zur Bewertung von Modellen für Klassifizierungs- und Regressionsaufgaben. Diese Metriken ermöglichen es Entwicklern, KI-Fairness in Bezug auf Folgendes zu quantifizieren:

- Demografische Parität: Stellt sicher, dass die Auswahlraten über alle Gruppen hinweg konsistent sind.

- Ausgeglichene Chancen (Equalized Odds): Gleicht die Raten korrekter und inkorrekter Klassifizierungen über alle demografischen Gruppen hinweg aus.

- Parität der wahren Positivrate (True Positive Rate Parity): Stellt sicher, dass qualifizierte Personen unabhängig von ihrer Gruppe gleich behandelt werden.

Fairlearn kann beispielsweise einen Kreditdatensatz analysieren, um festzustellen, ob sich die falschen Ablehnungsraten (False Positive Rates oder FPR) zwischen männlichen und weiblichen Antragstellern unterscheiden. Wenn die Raten ungleich sind, ist das ein Warnsignal für Verzerrungen.

Zum besseren Verständnis betrachten Sie ein hypothetisches Szenario im Gesundheitswesen: Ein prädiktives Modell empfiehlt Behandlungspläne. Wenn eine Demografie trotz gleicher medizinischer Bedürfnisse konsequent weniger aggressive Behandlungen erhält, würde das Modell KI-Fairness-Tests wie Equalized Odds nicht bestehen. Fairlearns Metriken helfen, solche Ungleichheiten zu identifizieren.

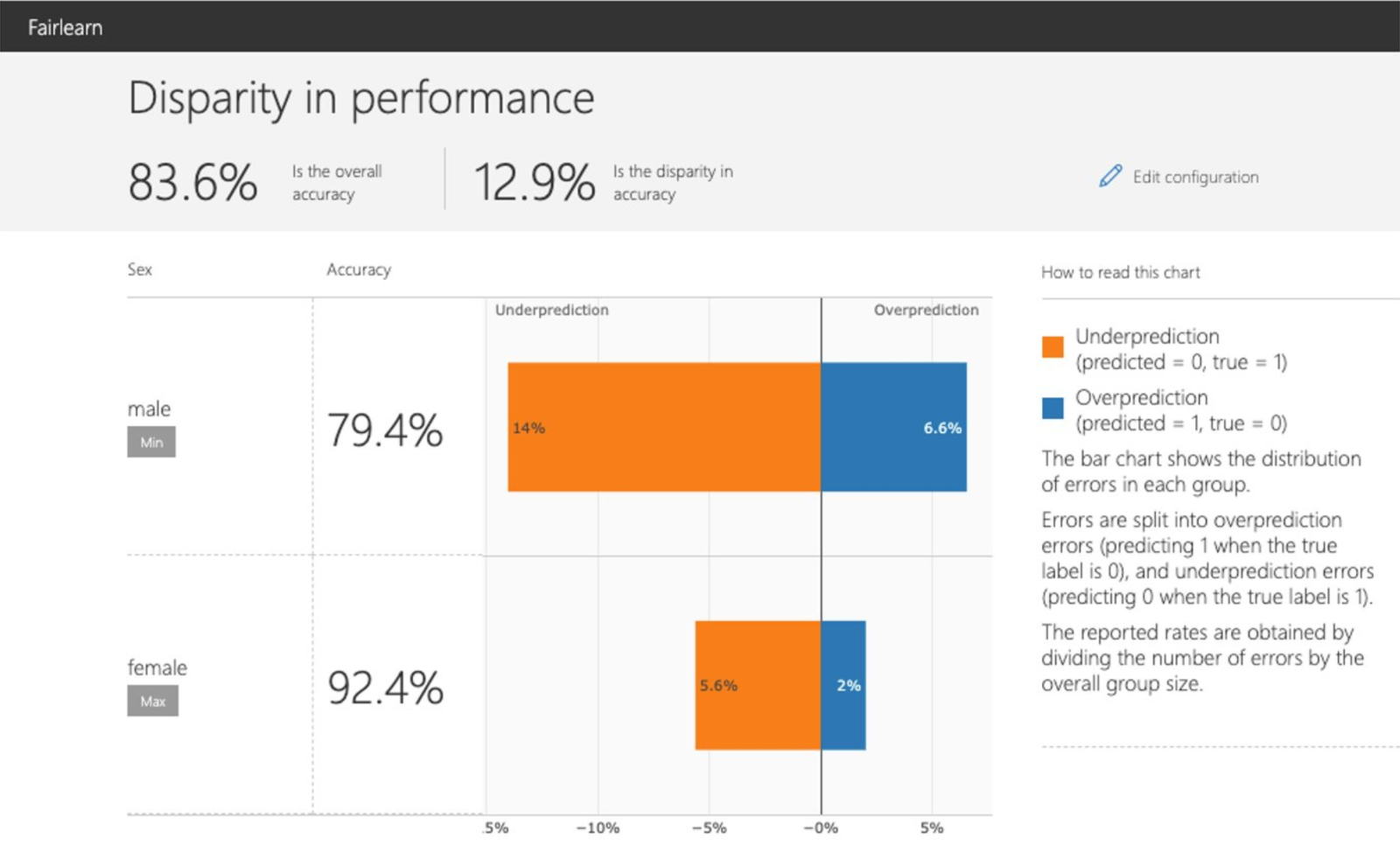

2. Interaktives Visualisierungs-Dashboard

Fairlearns Dashboard ist eine große Hilfe, um KI-Fairness-Metriken zu verstehen. Es ermöglicht Ihnen:

- Sensible Attribute wie Geschlecht oder Alter für KI-Fairness-Bewertungen auszuwählen.

- Zu vergleichen, wie verschiedene Modelle in Bezug auf KI-Fairness und Genauigkeit abschneiden.

- Zu visualisieren, wie Ergebnisse über demografische Gruppen hinweg variieren.

Diese Funktion erleichtert es, Kompromisse zu erkennen und Ergebnisse an Stakeholder zu kommunizieren. Das intuitive Design stellt sicher, dass auch nicht-technische Benutzer die Auswirkungen von KI-Fairness-Metriken erfassen können, was die Zusammenarbeit zwischen technischen Teams und Entscheidungsträgern fördert.

Stellen Sie sich vor, Sie präsentieren einen KI-Fairness-Bericht nicht-technischen Stakeholdern – die klaren Visualisierungen des Dashboards schließen die Lücke und stellen sicher, dass jeder die Auswirkungen von Verzerrungen und die notwendigen Schritte zu deren Minderung versteht.

3. Algorithmen zur Minderung von Ungerechtigkeit

Fairlearn bietet zwei Arten von Algorithmen zur Bekämpfung von Verzerrungen:

- Nachbearbeitungsalgorithmen (Postprocessing Algorithms): Diese passen die Vorhersagen eines bereits trainierten Modells an. Der ThresholdOptimizer setzt beispielsweise gruppenspezifische Schwellenwerte, um Ungleichheiten zu reduzieren, ohne das Modell neu zu trainieren.

- Reduktionsalgorithmen (Reduction Algorithms): Diese gewichten Trainingsdaten iterativ neu, um fairere Modelle zu erstellen. Tools wie GridSearch und ExponentiatedGradient ermöglichen es Ihnen, KI-Fairness und Leistung auszugleichen, während der Zugriff auf sensible Attribute während der Bereitstellung vermieden wird.

Die Flexibilität dieser Algorithmen stellt sicher, dass sie sich an verschiedene geschäftliche und rechtliche Anforderungen anpassen können. Darüber hinaus bieten sie Organisationen die Möglichkeit, mehrere Kompromisse zwischen KI-Fairness und Leistung zu testen, bevor ein Modell bereitgestellt wird.

Für eine Rekrutierungsanwendung können diese Algorithmen beispielsweise Chancengleichheit für unterrepräsentierte Gruppen gewährleisten, ohne Kompromisse bei der Auswahl der am besten qualifizierten Kandidaten einzugehen.

KI-Fairness: Fairlearn in Aktion (Fallstudie Kreditvergabe)

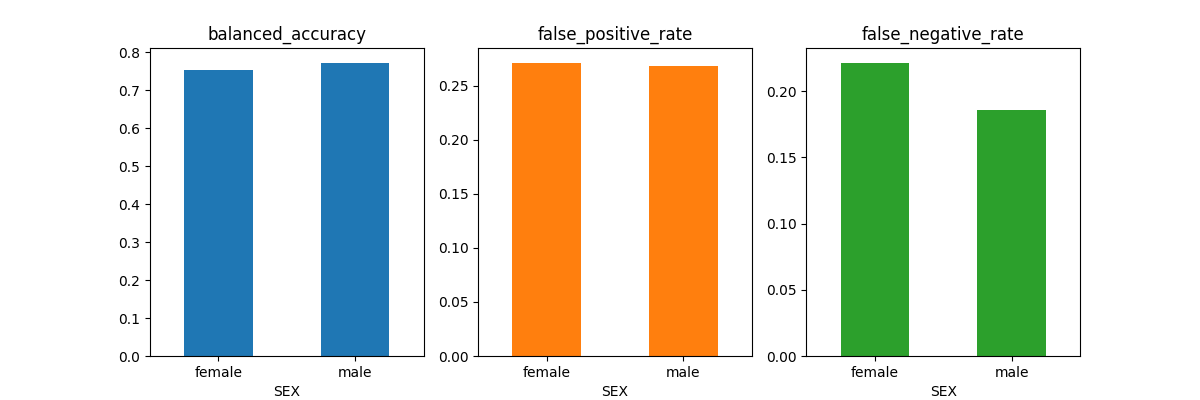

Die Fallstudie des Whitepapers demonstriert das Potenzial von Fairlearn anhand eines Datensatzes von über 300.000 Kreditanträgen. Der Datensatz enthält sensible Merkmale wie Geschlecht und Alter, und das Ziel war es, die Ausfallwahrscheinlichkeit (PD) vorherzusagen. Lassen Sie uns die Ergebnisse aufschlüsseln:

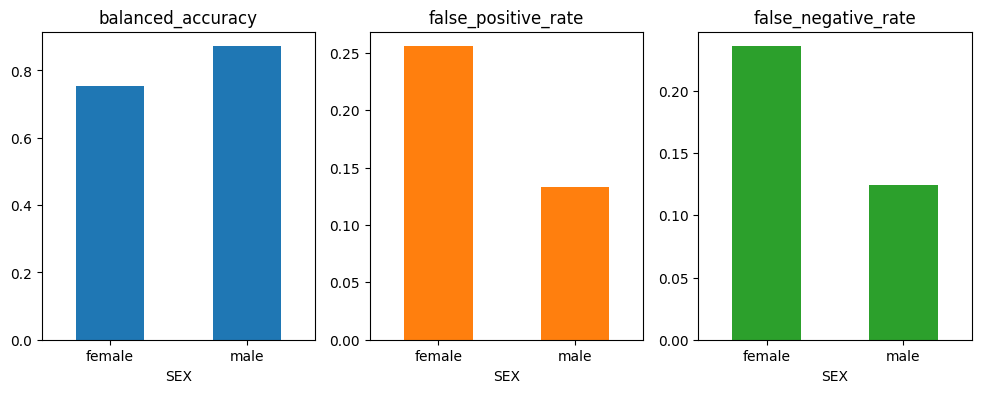

Anfängliche Modellleistung

Ein Basis-PD-Modell, das mit LightGBM trainiert wurde, erreichte eine hohe Genauigkeit, offenbarte jedoch erhebliche Lücken in der KI-Fairness:

- Falsch-Positiv-Rate (FPR): Männliche Antragsteller wurden häufiger abgelehnt, selbst wenn sie kreditwürdig waren.

- Falsch-Negativ-Rate (FNR): Weibliche Antragstellerinnen waren nach der Genehmigung eher geneigt, in Verzug zu geraten.

- Differenz der ausgeglichenen Chancen (Equalized Odds Difference): Es gab eine 8%ige Lücke zwischen den Gruppen, was auf eine Verzerrung hindeutet.

Diese Ergebnisse verdeutlichen, wie scheinbar leistungsstarke Modelle tiefe Ungleichheiten bergen können, und unterstreichen die Notwendigkeit von KI-Fairness-Bewertungen als Standardpraxis.

KI-Fairness: Wie Fairlearn geholfen hat?

Durch die Anwendung der Fairlearn-Minderungstools erzielte das Team bemerkenswerte Ergebnisse:

1. ThresholdOptimizer: Dieser Nachbearbeitungsansatz reduziert die Differenz der ausgeglichenen Chancen (Equalized Odds Difference) auf 1 %, während die Gesamtgenauigkeit erhalten bleibt.

2. GridSearch: Dieser Reduktionsalgorithmus erzielte ähnliche Verbesserungen der KI-Fairness, ohne dass sensible Attribute während der Bereitstellung benötigt wurden.

Das Ergebnis?

Ein faireres Modell, das die Geschäftsziele nicht beeinträchtigte. Das Fairlearn-Toolkit ermöglichte es dem Team, Kompromisse zwischen KI-Fairness und Leistung effektiv zu navigieren, und demonstrierte, dass ethische KI-Praktiken sowohl erreichbar als auch praktikabel sind.

Diese Fallstudie unterstreicht eine wichtige Lektion: KI-Fairness-Tools wie Fairlearn sollten in die Modellentwicklungspipelines integriert werden, anstatt nachträglich berücksichtigt zu werden. Proaktives Entgegenwirken von Verzerrungen vermeidet nicht nur potenzielle rechtliche Fallstricke, sondern baut auch Vertrauen bei den Endnutzern auf.

KI-Fairness: Umgang mit Kompromissen unter Berücksichtigung des menschlichen Faktors

Fairlearns Tools sind leistungsstark, aber bei KI-Fairness geht es nicht nur um Metriken und Algorithmen. Es ist eine soziotechnische Herausforderung, die Folgendes erfordert:

- Transparenz: Klare Kommunikation von Kompromissen und deren Auswirkungen.

- Ethische Aufsicht: Zusammenarbeit mit Rechtsexperten, um die Einhaltung von Antidiskriminierungsgesetzen zu gewährleisten.

- Kontinuierliche Überwachung: Regelmäßige Überprüfung der Modelle, um sicherzustellen, dass sie fair bleiben, während sich gesellschaftliche Normen entwickeln.

KI-Fairness ist keine einmalige Aufgabe. Es ist ein fortlaufendes Engagement, das Richtige zu tun. Organisationen müssen eine Kultur der Verantwortlichkeit fördern, in der KI-Fairness-Bewertungen in jede Phase des KI-Lebenszyklus integriert sind.

Darüber hinaus ist die Zusammenarbeit über Abteilungen hinweg entscheidend. Datenwissenschaftler, Ethiker, Rechtsteams und Führungskräfte müssen zusammenarbeiten, um technische Machbarkeit mit ethischen Imperativen in Einklang zu bringen. Offene Diskussionen über KI-Fairness können blinde Flecken aufdecken und zu ganzheitlicheren Lösungen führen.

Bevor wir fortfahren, wenn Sie nach verantwortungsvollen KI-Diensten wie KI-gesteuerten Einblicken und Integration suchen, sehen Sie sich die verantwortungsvollen KI-Angebote von OpenSense Labs an.

KI-Fairness: Warum Fairness wichtig ist?

Hier geht es nicht nur darum, Rechtsstreitigkeiten zu vermeiden oder Vorschriften einzuhalten. Es geht um Vertrauen. Finanzdienstleistungen beeinflussen das Leben auf tiefgreifende Weise, von der Gewährung von Chancen bis zur Gewährleistung von Sicherheit. Durch die Einbettung von KI-Fairness in Systeme bauen Organisationen Glaubwürdigkeit auf und tragen zu einer gerechteren Gesellschaft bei.

Unfaire KI-Systeme riskieren, das Vertrauen der Öffentlichkeit zu untergraben, was weitreichende Konsequenzen haben kann. In einer Zeit, in der Transparenz und Rechenschaftspflicht zunehmend gefordert werden, wird KI-Fairness zu einem Wettbewerbsvorteil. Unternehmen, die KI-Fairness priorisieren, sind besser positioniert, um Kundenloyalität zu gewinnen und ihren Ruf zu wahren.

Fairlearn zeigt, dass KI-Fairness nicht auf Kosten der Leistung gehen muss. Es ist ein Toolkit für Organisationen, die den Weg in der ethischen KI weisen wollen. Über Finanzdienstleistungen hinaus können die Prinzipien und Tools von Fairlearn im Gesundheitswesen, bei der Einstellung, in der Bildung und in unzähligen anderen Bereichen angewendet werden, in denen eine gerechte Entscheidungsfindung entscheidend ist.

Im Personalwesen kann Fairlearn beispielsweise sicherstellen, dass qualifizierte Kandidaten aus unterrepräsentierten Gruppen aufgrund historischer Verzerrungen in den Rekrutierungsdaten nicht übersehen werden. In der Bildung kann es dazu beitragen, einen gerechten Zugang zu Ressourcen wie Stipendien oder fortgeschrittenen Lernprogrammen zu gewährleisten.

Lesen Sie auch:

1. API-Dokumentationstool: Die 10 besten Tools für 2025

2. Drupal Debug: Effektive Techniken und Tools

3. Jedes Tool, das Sie für das Drupal 9 Upgrade benötigen könnten

4. 9 Tipps und Tools, um ein produktiverer Webentwickler zu werden

KI-Fairness: Praktische Schritte zur Integration von Fairness

Für Organisationen, die KI-Fairness-orientierte Praktiken einführen möchten, können die folgenden Schritte hilfreich sein:

-

Frühzeitig beginnen: Integrieren Sie KI-Fairness-Bewertungen bereits in den Phasen der Datenerfassung und -vorverarbeitung. Verzerrungen in Rohdaten können sich durch die gesamte Pipeline fortpflanzen.

-

Teams schulen: Stellen Sie sicher, dass jeder, der an der KI-Entwicklung beteiligt ist, die Bedeutung von KI-Fairness und die verfügbaren Tools zu deren Erreichung versteht.

-

Toolkits nutzen: Verwenden Sie Fairlearn und ähnliche Frameworks, um Verzerrungen während des gesamten KI-Lebenszyklus zu bewerten und zu mindern.

-

Stakeholder einbeziehen: Berücksichtigen Sie vielfältige Perspektiven in Diskussionen über KI-Fairness, um sicherzustellen, dass die Lösungen reale Bedenken ansprechen.

-

Iterieren und verbessern: Betrachten Sie KI-Fairness als ein kontinuierliches Ziel und nicht als einen festen Meilenstein. Aktualisieren Sie Modelle regelmäßig, um Änderungen in gesellschaftlichen Werten und Erwartungen widerzuspiegeln.

Die Verankerung dieser Schritte in den Unternehmenspraktiken schafft eine Grundlage für eine verantwortungsvolle KI-Entwicklung. Über technische Korrekturen hinaus gewährleistet die Förderung einer Kultur, die KI-Fairness schätzt, nachhaltigen Fortschritt.

Wichtige Erkenntnisse

Das Whitepaper von Microsoft und EY ist mehr als ein technischer Leitfaden; es ist ein Aufruf zum Handeln. Fairlearn beweist, dass Fairness erreichbar ist, ohne die Leistung zu opfern. Durch die Nutzung solcher Tools können Organisationen KI-Systeme aufbauen, die genau, verantwortungsvoll und fair sind.

Bei OpenSenseLabs nehmen wir Fairness bei jedem Projekt, das wir übernehmen, ernst. Wir verstehen den tiefgreifenden Einfluss, den unsere Modelle auf Einzelpersonen und Gemeinschaften haben, und wir machen es uns zur Aufgabe, Gleichheit und Transparenz zu priorisieren. Tools wie Fairlearn spielen eine Schlüsselrolle dabei, uns beim Aufbau von Systemen zu helfen, die nicht nur effizient, sondern auch gerecht und verantwortungsvoll sind.

Während wir voranschreiten, wird die Fairness in der KI nur noch an Bedeutung gewinnen. Durch die Einführung bewährter Verfahren und die Nutzung innovativer Tools können wir sicherstellen, dass KI als Kraft zum Guten dient, Einzelpersonen stärkt und Chancen für alle schafft.

Abonnieren

Verwandte Blogs

API-Dokumentationstool: Die 10 besten Tools für 2025

Eine Google-Suche nach „Bestes API-Dokumentationstool“ liefert zahlreiche Ergebnisse. Die wachsende Anzahl von API…

6 verbreitete Irrtümer über Softwaretests – widerlegt

Eine einwandfreie Produktauslieferung erfordert eine perfekte Kombination aus Entwicklungs- und Testaufwand. Das Testen…

Mit Ant Design React-Komponenten wie ein Profi erstellen

Die meisten Enterprise-Lösungen setzen auf den React-Stack, um eine robuste Plattform für verbesserte Bereitstellung und…