Organisationen weltweit konzentrieren sich heute auf Daten, um bessere Ergebnisse zu erzielen. Sie sind bestrebt, exzellente Dienstleistungen anzubieten und suchen nach Möglichkeiten, vielfältige, verbesserte Produkte für ihre Kund:innen zu entwickeln. Es ist eine bekannte Tatsache, dass Daten in dieser digitalisierten Ära eine entscheidende Rolle dabei spielen können, Unternehmen beim Erreichen ihrer gewünschten Ziele und Vorgaben zu unterstützen. Doch reicht es aus, allein auf Daten – das Rohmaterial – zu setzen, um Erkenntnisse zu gewinnen und Wert zu schaffen? In diesem Artikel werden wir untersuchen, wie Daten optimal gehandhabt werden, um die erwarteten Geschäftsergebnisse zu erzielen.

Eine umfassende Studie zur wachsenden Bedeutung von Daten in der modernen Zeit

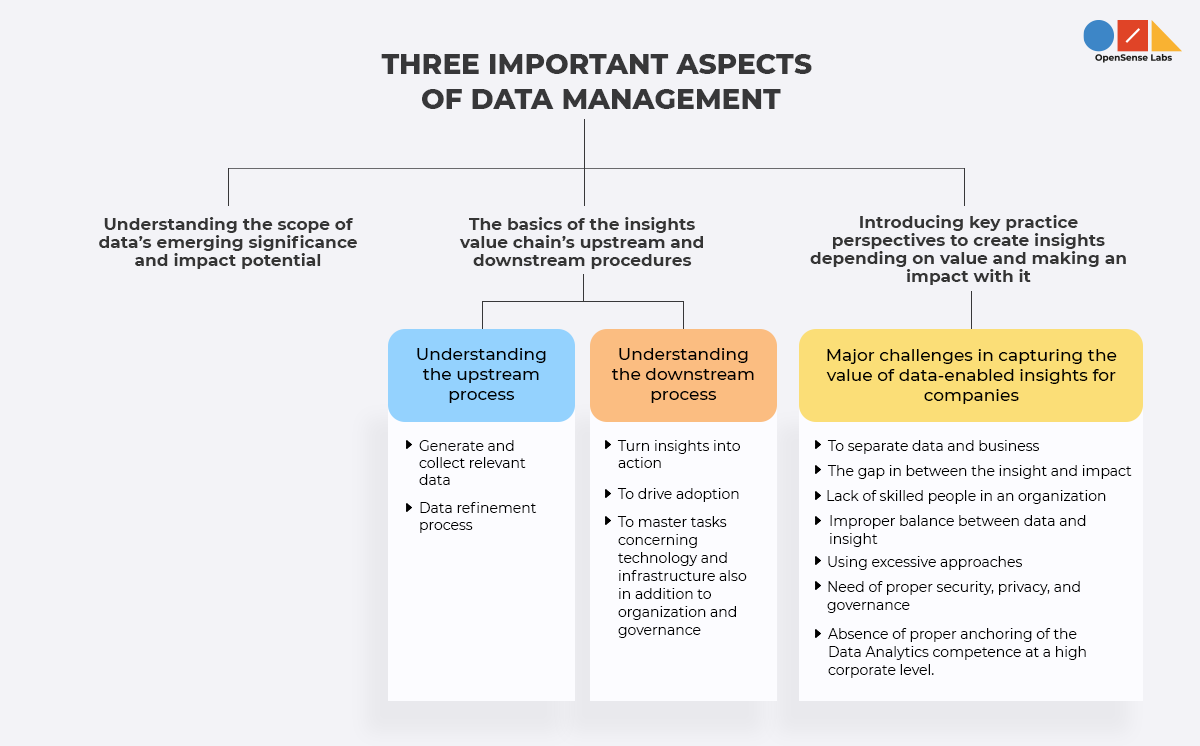

Digitale Transformation ist in der neuen Normalität unerlässlich. Vor allem ist sie ohne ein starkes Datenmanagement nicht realisierbar. Daher werden wir in diesem Abschnitt eine umfassende Studie über Datenmanagement, die Datenwertschöpfungskette und ihre Bedeutung in der modernen Welt betrachten. Beginnen wir also mit dem Verständnis von drei wichtigen Aspekten des Datenmanagements, die von der datengesteuerten Organisation McKinsey empfohlen werden.

Das Verständnis des Umfangs der aufkommenden Bedeutung und des Wirkungspotenzials von Daten

Es wird beobachtet, dass eine riesige Datenmenge hauptsächlich durch das Internet der Dinge (IoT) generiert wird. In den letzten fünf Jahren ist die Verfügbarkeit von Daten rapide gewachsen und wird voraussichtlich auch in naher Zukunft weiter zunehmen. Es wurden neue Tools entwickelt, die all diese verfügbaren Daten in Erkenntnisse und schließlich in konkrete Maßnahmen umwandeln können. Maschinelles Lernen, ein Teilbereich der Künstlichen Intelligenz (KI), hilft dabei, Algorithmen zur Analyse riesiger Datenmengen zu nutzen. Sie werden feststellen, dass Big Data und Advanced Analytics schnelle Fortschritte machen und aktiv zum Datenmanagement beitragen. Big Data und Analysen bieten verschiedenen Personen innerhalb eines Unternehmens unterschiedliche Werte. Für einige Fachleute können sie als strategisches Planungsinstrument dienen, als bequeme Möglichkeit, langfristige Geschäftsziele zu erkennen und sich auf diese zu konzentrieren. Für andere Fachleute bieten sie eine schnelle, intuitive Möglichkeit, Prozesse zu beschleunigen und den Weg für Veränderungen zu ebnen.

Auch visuelle Analyse- und Discovery-Tools tragen dazu bei, den Weg zur Datenerkenntnis schnell und einfach zu gestalten. Anstatt zu versuchen, aus einer Gruppe vordefinierter Berichte oder einfacher statischer Dashboards Bedeutung zu extrahieren, können Benutzer:innen mithilfe intuitiver Datenvisualisierung schnell Erkenntnisse aus Daten gewinnen. Solche modernen visuellen Analysetools bieten benutzerfreundliche Datenaufbereitungsfunktionen für ein wesentlich besseres Daten-Wrangling.

Wir sehen, dass Daten nicht nur im Volumen zugenommen haben, sondern auch eine enorme Fülle und Vielfalt gewonnen haben. Die Ära, in der wir leben, dreht sich vollständig um die Digitalisierung. Daten können von allem generiert werden, von Kameras und Verkehrssensoren bis hin zu Herzfrequenzmessern, was tiefere Einblicke in das Verhalten von Menschen und „Dingen“ ermöglicht. Folglich können Daten als die neue Unternehmenswertklasse betrachtet werden, und Unternehmen erzielen auch mühelos geschäftliche Auswirkungen mit Daten. Unternehmen können nun alles, was sie tun, digitalisieren, und die Digitalisierung von Kundeninteraktionen liefert zudem relevante Informationen für Marketing, Vertrieb und Produktentwicklung. Darüber hinaus ermöglicht die Digitalisierung interner Prozesse die Generierung von Daten, die zur Optimierung von Abläufen und zur Steigerung der Produktivität genutzt werden können.

Die Grundlagen der Upstream- und Downstream-Prozesse der Insights-Wertschöpfungskette

Die rohe und grundlegendste Form von Daten ist praktisch wertlos, bis Sie ihr eine Stimme geben, indem Sie wertvolle Erkenntnisse daraus gewinnen. Nun, wie können Sie Daten zum Sprechen bringen? Jeder spricht heute über Big Data, Advanced Analytics, Maschinelles Lernen und sogar KI. Da die Menschen diesen neuen Technologien meist Priorität einräumen, wird den einzelnen technischen Komponenten der „Insights-Wertschöpfungskette“, wie wir sie nennen, mehr Bedeutung beigemessen. In Wirklichkeit ist jedoch die gesamte Reihe von Komponenten erforderlich, um den vollständigen Wert aus den verfügbaren Daten zu schöpfen.

1. Verständnis des Upstream-Prozesses

Lassen Sie uns die Upstream-Prozesse der Insights-Wertschöpfungskette verstehen.

Relevante Daten generieren und sammeln

Bei der Beobachtung, was Unternehmen im Bereich der Analytik tun, fielen zwei Trends auf. Erstens scheinen Algorithmen zu einer Ware zu werden; zum Beispiel bieten Google und Amazon kostenlosen Zugang zu ihren Analysebibliotheken. Zweitens kümmern sich diese Unternehmen selbst um ihre Daten, ohne Außenstehenden Zugang zu gewähren, da sie glauben, dass der Wert in den Daten selbst liegt. Das Sammeln riesiger Datenmengen ist nicht nur das Metier von Tech-Giganten. Der Wert von Daten kann auch in traditionellen Sektoren noch stärker erkannt werden. Zum Beispiel werden Joint Ventures zwischen Telekommunikationsunternehmen und Einzelhändlern aufgebaut, um Daten in größerem Maßstab zu sammeln. Eine solche verbesserte Datenerfassungsfähigkeit ist nicht nur für B2C-Umgebungen geeignet, sondern auch für B2B unerlässlich.

Sie sehen, dass mit zunehmendem Volumen der Datengenerierung und -sammlung die Datenrelevanz zu einer Priorität wird. Es ist unpraktisch, jeden Teil der Tera- und Petabytes an Daten, die jede einzelne Sekunde generiert werden, zu erfassen und zu speichern. Daher wird es hilfreich sein, durch die Definition spezifischer Anforderungen, abhängig von bestimmten Anwendungsfällen, relevante Daten zu erfassen.

Ein weiterer wichtiger Aspekt der Datengenerierung und -sammlung ist die Daten-Layering. Anstatt alle unverbundenen Daten auf einmal in die Analyseschiene zu werfen, können Sie diese sorgfältig in verschiedene logische Schichten organisieren und dann eine Logik anwenden, mit der Sie diese Schichten stapeln können, was zur Generierung aussagekräftiger Daten beiträgt.

Datenveredelungsprozess

Nachdem das Unternehmen die relevanten Rohdaten erfasst hat, muss der Prozess der Umwandlung riesiger Mengen unraffinierter Rohdaten in umsetzbare Erkenntnisse begonnen werden. Dieser zweistufige Prozess umfasst die Anreicherung und Extraktion.

- Schritt 1: Daten mit ergänzenden Informationen oder Domänenwissen anreichern

Nachdem die Rohdaten gesammelt, bereinigt und kombiniert wurden, beginnt einer der wichtigsten Veredelungsschritte, nämlich die Transformation und Anreicherung von Daten mit ergänzendem und domänenspezifischem Wissen, was ebenfalls ein komplexer Vorgang ist.

In der heutigen Welt gelten sowohl Mensch als auch Maschine als der optimale Ansatz zur Datenanreicherung. Doch aufgrund der Fortschritte im Bereich der KI könnte sich dies eines Tages ändern. Bevor man mit dem maschinellen Lernen beginnt, müssen daher menschliche Expert:innen hinzugezogen werden, die ihr Fachwissen nutzen, um ihre Hypothesen zu erläutern. Ein Data Scientist muss dann ergänzende Informationen oder Domänenwissen in Variablen übersetzen, d.h. kodifizieren. Konkret bedeutet dies, die vorhandenen Daten in neue Variablen umzuwandeln, was als Feature Engineering bezeichnet werden kann.

- Schritt 2: Erkenntnisse mittels maschinellem Lernen extrahieren

Der nächste Schritt, um Rohdaten nutzbar zu machen, umfasst die eigentliche Mathematik und Datenverarbeitung, auf die sich Data Scientists am meisten freuen. Man könnte jedoch argumentieren, dass keine menschliche Komponente erforderlich ist, da es ausgeklügelte Algorithmen gibt, die alle Muster finden können. Die Realität ist, dass die Kombination aus menschlichem, hypothesengesteuertem Input und den neuesten erstaunlichen Mustern, die Maschinen aufdecken, die erfolgreiche Kombination darstellt. Durch die Schaffung neuer Features kann die Maschine bessere Muster finden und sogar Menschen dabei helfen, diese Muster besser zu beschreiben und perfekt darauf zu reagieren. In diesem Schritt geht es hauptsächlich darum, zahlreiche Methoden zur Erkennung dieser Muster zu nutzen. Grundsätzlich kann man zwischen deskriptiver Analyse (was genau geschah in der Vergangenheit und warum?), prädiktiver Analyse (was wird in Zukunft geschehen?) und präskriptiver Analyse (wie kann sich die Zukunft ändern?) unterscheiden. In diesen Schritten werden ausgeklügelte Methoden wie KI und maschinelles Lernen eingesetzt.

2. Verständnis des Downstream-Prozesses

Der Downstream-Prozess besteht aus nicht-technischen Komponenten. Er umfasst Menschen, Prozesse und Geschäftsverständnis durch einen systematischen Ansatz, der die neuen datengesteuerten Erkenntnisse mithilfe einer Gesamtstrategie und eines Betriebsmodells operationalisieren kann, was zu einem besseren Wert aus Datenerkenntnissen und deren Umsetzung führt.

Erkenntnisse in Handlungen umsetzen

Nachdem signifikante Erkenntnisse aus den Modellen extrahiert wurden, ist der nächste wesentliche Schritt, diese Erkenntnisse in Handlungen umzusetzen, um geschäftliche Auswirkungen zu erzielen. Sie müssen ein klares Verständnis der Datenanalyse-Wertschöpfungskette haben. Es wird auch festgestellt, dass Domänenwissen und Geschäftsverständnis eine wichtige Rolle spielen, um auf Erkenntnisse reagieren zu können. Um Erkenntnisse in Handlungen umzusetzen, sind zwei Dinge erforderlich: Erstens ist in diesem Fall Domänenwissen unerlässlich. Auch wenn die Mathematik der vorausschauenden Wartung für Pumpen auf Ölplattformen der von Telekommunikationsnetzen ähneln mag, werden die später zu ergreifenden Maßnahmen unterschiedlich sein. Zweitens, selbst wenn Sie Klarheit darüber haben, welche Maßnahmen zu ergreifen sind, kann der Erfolg immer noch davon abhängen, wie diese Maßnahmen umgesetzt werden. Folglich müssen Sie die Prozesse und Strukturen priorisieren. Zum Beispiel können auf der Strukturebene Callcenter neu organisiert und „Save Desks“ eingerichtet werden, um die Einstellung spezialisierter Agenten für die Kundenbindung zu unterstützen. Abgesehen von dieser organisatorischen Strukturierung müssen Anreizsysteme entwickelt werden, um den Erfolg dieser speziellen Agenten zu motivieren, da die Bindungsraten und nicht die durchschnittlichen Bearbeitungszeiten ihre Erfolgsmaße sind. Schließlich kann auf der Prozessebene Automatisierung für Aktivitäten wie Preisentscheidungen auf Online-Plattformen eingeführt werden.

Adoption vorantreiben

Wenn es um Daten und Analysen geht, wird häufig der Fehler gemacht, sich stärker auf das benötigte neue technische Personal zu konzentrieren. Obwohl dies sicherlich eine wichtige und äußerst knappe Ressource auf dem Markt ist, muss die eigentliche Veränderung bei den regulären Mitarbeiter:innen stattfinden. Diese regulären Mitarbeiter:innen müssen ihren Analytics Quotient (AQ) erhöhen und datenanalytischer werden. Auch die Mitarbeiter:innen in Marketing, Kundenbindung und Wartung (u.a.) müssen verstehen, welche Fragen in Bezug auf Daten und Analysen gestellt werden können, und sie sollten in der Lage sein, die Antworten zu übersetzen, d.h. die Erkenntnisse in Handlungen umzusetzen.

Aufgaben in Bezug auf Technologie und Infrastruktur sowie Organisation und Governance meistern

Organisationen können auf die Erkenntnisse aus fortgeschrittenen Analysen reagieren und sogar Auswirkungen erzielen, mithilfe von Technologie und Infrastruktur sowie Organisation und Governance. Meistens benötigen Organisationen die richtigen, benutzerfreundlichen Tools – z.B. Dashboards oder Empfehlungs-Engines, um dem Personal die Extraktion geeigneter Erkenntnisse zu ermöglichen, und eine Arbeitsumgebung, die die Integration dieser Erkenntnisse erleichtert, z.B. eine Governance, die die erforderlichen Veränderungen innerhalb der Organisation zulässt und verwaltet.

Einführung wichtiger Praxisperspektiven zur Wertschöpfung aus Erkenntnissen und deren Wirkung

Nachdem wir das Umfeld, in dem Daten an Bedeutung gewinnen, und die Schritte, die die Upstream- und Downstream-Prozesse der Insights-Wertschöpfungskette umfassen, untersucht haben, möchte ich Sie nun durch die größten Herausforderungen führen, die Unternehmen bei der Wertschöpfung aus datengestützten Erkenntnissen begegnen.

Es gibt drei strukturelle Herausforderungen, die Kunden daran hindern, den maximalen Geschäftsnutzen aus Daten zu ziehen.

- Trennung von Daten und Geschäft. In den meisten Unternehmen sind Data Science und Geschäftsimplementierung vollständig getrennt. Dies führt zu einem mangelnden Verständnis auf der Geschäftsseite, was erreichbar ist, und zur Entwicklung von Data-Science-Lösungen, die die Unternehmen nicht benötigen.

- Die Lücke zwischen Erkenntnis und Wirkung. In den meisten Fällen wird der wesentliche Schritt, von der Erkenntnis zur wertschöpfenden Umsetzung auf Basis von Erkenntnissen überzugehen, nie richtig vollzogen. Die Unternehmenskunden glauben an die Bedeutung von Analysen und haben stets ein oder mehrere Proof of Concepts (PoCs) durchgeführt. Diese PoCs sind meist voneinander isoliert und entwickeln sich nie zu erfolgreichen Anwendungsfällen.

- Fehlende Verankerung der Datenanalysekompetenz auf hoher Unternehmensebene. Es wird beobachtet, dass der geschäftliche Nutzen aus datengestützten Erkenntnissen nur dann eintritt, wenn die Datenanalyse tief innerhalb und durchgängig im gesamten Unternehmen implementiert wird. Dies erfordert ein starkes Engagement und eine klare Richtung der Führungsebene sowie die Befugnis, diese Art der erkenntnisorientierten Transformation voranzutreiben, und die meisten Unternehmen müssen dieses Maß an Unternehmensengagement noch erreichen.

Hier sind einige der häufigsten Herausforderungen, die auf dem Weg zur analytischen Exzellenz auftreten.

Mangel an qualifizierten Mitarbeiter:innen in einer Organisation

Nachdem gut strukturierte Daten vorhanden sind, benötigen Sie als Nächstes die richtigen Personen mit den passenden Fähigkeiten. Doch einigen Organisationen mangelt es an solchen qualifizierten Mitarbeiter:innen, was die Organisation an der ordnungsgemäßen Nutzung der verfügbaren Daten hindert. In solchen Situationen muss das Talentmanagement die erforderlichen Initiativen ergreifen, um die richtigen Talente in der Organisation einzustellen.

Unzureichendes Gleichgewicht zwischen Daten und Erkenntnissen

Beim Versuch, den ROI von Analysen zu steigern, stehen Unternehmen vor einer der häufigsten Herausforderungen: den Daten selbst. Die eigentliche Herausforderung für die Mitarbeiter:innen besteht darin, aus einer riesigen Datenmenge wertvolle Erkenntnisse zu gewinnen. Es ist wichtig, dass das Team weiß, welche Daten für welchen Zweck verwendet werden, wo genau sie zu finden sind und wie sie darauf zugreifen können. Dies kann als Daten-Demokratisierung bezeichnet werden.

Um diese Herausforderung anzugehen, müssen Sie zwei Hauptziele festlegen: Die Mitarbeiter:innen des Unternehmens müssen eine einzige Quelle der Wahrheit für Daten haben, und das Unternehmen muss Daten als strategisches, wertvolles Gut nutzen, das nicht missbraucht werden darf.

Übermäßige Ansätze verwenden

Es hat sich gezeigt, dass maschinelles Lernen und andere KI-Disziplinen zu den besten Lösungen für die Steigerung des profitablen Wachstums sowie die Generierung und Skalierung von Analysen gehören. Aufgrund der Dringlichkeit, mit der Unternehmen maschinelles Lernen und KI einführen, stehen Daten- und Analyseleiter:innen vor der Herausforderung, übermäßige Ansätze zu verfolgen, d.h. die neuesten Technologien und Methoden zu nutzen, ohne deren tatsächliche Notwendigkeit in ihren Organisationen zu identifizieren.

Notwendigkeit angemessener Sicherheit, Datenschutz und Governance

Es sollte Ihnen bekannt sein, dass Sicherheit und Datenschutz wichtige Faktoren sind, die den Erfolg eines Datenprogramms beeinflussen. Beim Bereitstellen des Datenzugriffs müssen Sie sicherstellen, dass jeder Zugriffspunkt und jede Pipeline, die er berührt, vollständig gesichert ist. Darüber hinaus sollten Sie auch frühzeitig den richtigen Data-Governance-Ansatz in Betracht ziehen, unter Berücksichtigung der langfristigen Ziele und Ergebnisse, was Ihnen die Ausführung und Skalierung von Analysen erheblich erleichtern wird. Notwendige Ansätze umfassen die Sicherstellung, dass Ihr gesamter Daten-Stack, einschließlich Data Warehouses, Katalogen und BI-Plattformen, den Data-Governance-Richtlinien Ihrer Organisation, Branche und Region entspricht.

Best Practices

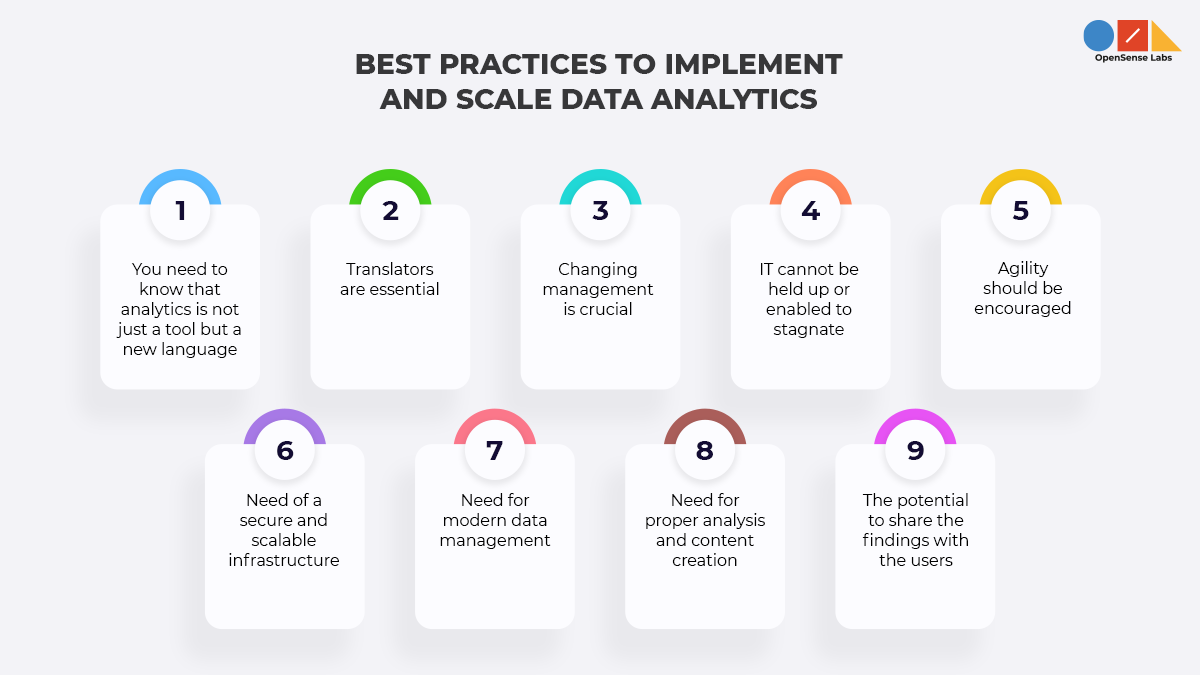

Lassen Sie uns nun einige der Best Practices für die Ausführung und Skalierung von Datenanalysen betrachten.

Sie müssen wissen, dass Analysen nicht nur ein Werkzeug, sondern eine neue Sprache sind

Um auf Analyseergebnisse zu reagieren, muss das Unternehmen die Implikationen dieser Ergebnisse verstehen.

Übersetzer:innen sind unerlässlich

Sie müssen sich auf die Einstellung und Schulung von Talenten konzentrieren, die als Schnittstelle zwischen Datenanalyse und Geschäft fungieren.

Veränderungsmanagement ist entscheidend

Die Geschäftsanwender:innen sollen den Analyseergebnissen vertrauen und in der Lage sein, darauf zu reagieren.

Die IT darf nicht blockiert oder zum Stillstand gebracht werden

Sie müssen die Unternehmens-IT zunächst „umgehen“, um schnell zu starten und das Konzept frühzeitig zu demonstrieren, müssen die IT jedoch schließlich rechtzeitig und stetig für die Skalierung einbeziehen.

Agilität sollte gefördert werden

Die Organisation sollte in der Lage sein, Risiken einzugehen, um große Erfolge zu erzielen, ohne Angst vor dem Scheitern zu haben. Sie müssen eine experimentelle Denkweise annehmen und den Test-and-Learn-Ansatz verfolgen. Die funktionsübergreifenden Teams des Unternehmens sind notwendig, um mit schnellen Test-and-Learn-Zyklen Schritt zu halten.

Bedarf an einer sicheren und skalierbaren Infrastruktur

Da Organisationen Analysen im gesamten Unternehmen für die maximale Anzahl von Personen bereitstellen, besteht ein Bedarf an besseren Sicherheits- und Administrationskapazitäten. Es wird also eine sichere, skalierbare Infrastruktur benötigt, die die Self-Service-Datenanalyse unterstützen kann.

Bedarf an modernem Datenmanagement

Die modernen Business-Intelligence-Plattformen sollten in der Lage sein, Extraktions-, Transformations- und Lade-(ETL)-Prozesse sowie die Datenaufbereitung im Self-Service-Modus zu unterstützen. Sie sollten In-Memory- oder andere Datenspeicher- und Optimierungsmechanismen anbieten, die direkt in die Plattform integriert sind. Darüber hinaus sind Metadatenmanagement und Governance ebenfalls wichtige Fähigkeiten, die zur Weiterentwicklung der Analysen beitragen.

Bedarf an angemessener Analyse und Inhaltserstellung

Eine wichtige Tatsache ist, dass eine interaktive visuelle Exploration ein sehr leistungsfähiges Verfahren ist, das hilft, wesentlich bessere Erkenntnisse aus Daten zu gewinnen. Daher finden Datenexpert:innen heute Wege, Inhalte, Berechnungen und Algorithmen sowie analytische Inhalte zu erstellen, die dabei helfen, fortgeschrittenere Analysen über grundlegende Aggregationen hinaus zu nutzen.

Das Potenzial, die Ergebnisse mit den Benutzer:innen zu teilen

Um die Erkenntnisse für mehr Benutzer:innen zugänglich zu machen, sollten Unternehmen in der Lage sein, analytische Inhalte schnell in ein Dashboard, eine App, eine Web-App und ein Portal einzubetten. Sie möchten möglicherweise auch analytische Inhalte in Dashboards und Berichten veröffentlichen, drucken, verteilen, planen und Benachrichtigungen erhalten, die den Inhalt generieren. Auch die Kollaborations- und sozialen Funktionen ermöglichen es Benutzer:innen, die Ergebnisse zu teilen, den Inhalt zu prüfen und zu bewerten.

Lehren für Führungskräfte

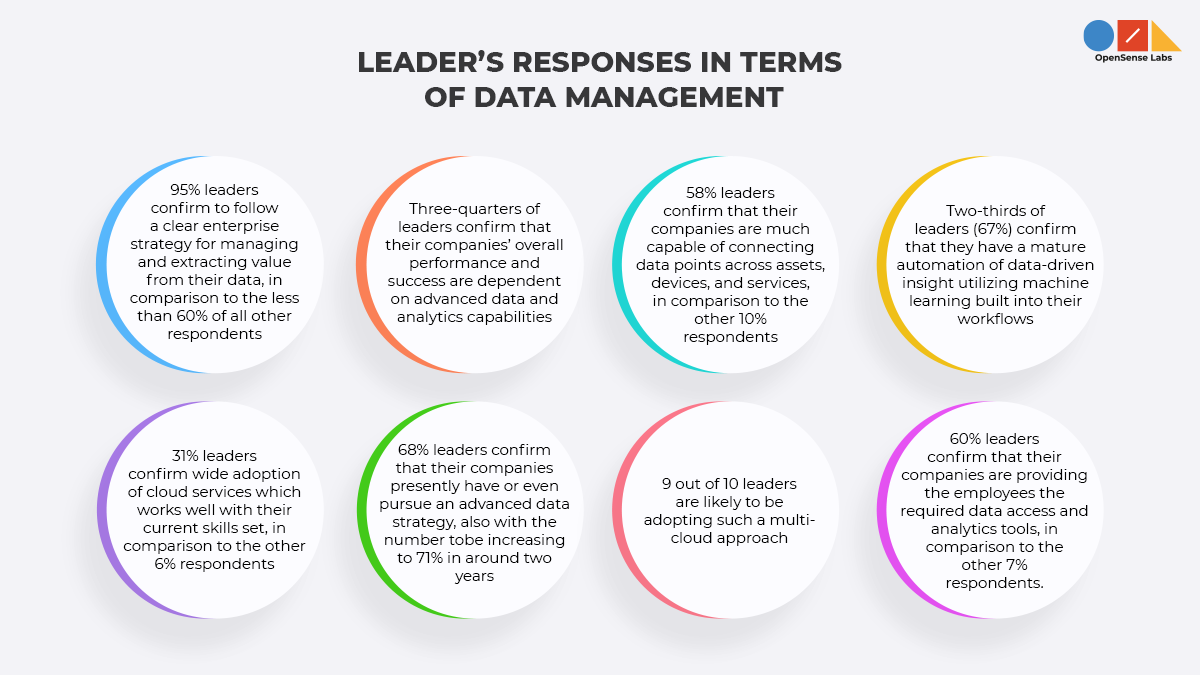

Nun möchte ich Sie durch einen Abschnitt führen, in dem wir herausfinden werden, wie Unternehmensführer:innen Daten auf intelligente Weise nutzen können, um Erkenntnisse zu generieren, die sich weiter in Wert umwandeln lassen. Laut der von der Harvard Business Review durchgeführten Umfrage haben sich ein Drittel der 311 Befragten als „Data-to-Value-Leader“ („Führungskräfte“) bezeichnet, da ihre Unternehmen sehr effizient darin sind, Daten zur Schaffung neuer Geschäftswerte zu nutzen.

Im Wesentlichen verfügen über 95 % dieser Führungskräfte über eine sehr klare Unternehmensstrategie für die ordnungsgemäße Verwaltung und Wertschöpfung aus ihren Daten sowie für das Sammeln und Integrieren externer Datenquellen, im Vergleich zu weniger als 60 % aller anderen Befragten. Solche Führungskräfte sind also intelligent, smart und auf dem neuesten Stand.

Während der Umfrage, als die Führungskräfte nach der Bedeutung von drei fortgeschrittenen Daten- und Analysefähigkeiten gefragt wurden, um Datenpunkte über eine Vielzahl von Assets, Geräten und Diensten hinweg zu verbinden; um Daten in Echtzeit abzurufen und zu analysieren; und um datengesteuerte Erkenntnisse zu automatisieren, versuchten sie, sich von den anderen Umfrageteilnehmern abzuheben. Fast drei Viertel der Führungskräfte gaben an, dass die Gesamtleistung und der Erfolg ihrer Unternehmen maßgeblich mit jeder dieser Fähigkeiten verbunden sind, während der Rest der Befragten dies viel seltener angab. Ähnlich bestätigt eine große Anzahl von Führungskräften, dass sie in jedem dieser Bereiche über ausgereifte Fähigkeiten verfügen. 58 % geben an, dass ihre Unternehmen sehr gut in der Lage sind, Datenpunkte über Assets, Geräte und Dienste hinweg zu verbinden, im Vergleich zu den anderen 10 % der Befragten. Dieselben 58 % bestätigen auch, dass ihre Unternehmen über ausgereifte Echtzeit-Datenzugriffs- und Analysefähigkeiten verfügen, im Vergleich zu den restlichen 6 % der Befragten. Außerdem geben etwa zwei Drittel der Führungskräfte (67 %) an, dass sie über eine ausgereifte Automatisierung datengesteuerter Erkenntnisse mittels maschinellem Lernen verfügen, das in ihre Workflows integriert ist, während dies nur 5 % der verbleibenden Befragten sagen.

Eine weitere Sache, die auffiel, war, wie die Führungskräfte die Einführung von Cloud-Diensten priorisieren. 31 % der Führungskräfte bestätigen eine breite Akzeptanz von Cloud-Diensten, die gut zu ihren aktuellen Fähigkeiten passen, im Vergleich zu den anderen 6 % der Befragten. In den Unternehmen gewinnen Multi-Cloud-Strategien an Bedeutung. Rund 68 % geben an, dass ihre Unternehmen derzeit eine solche Strategie verfolgen oder anstreben, wobei die Zahl in etwa zwei Jahren auf 71 % ansteigen soll. Neun von zehn Unternehmen werden voraussichtlich einen solchen Multi-Cloud-Ansatz verfolgen. Dieser Multi-Cloud-Ansatz bietet eine wesentlich höhere betriebliche Effizienz, die von 42 % aller Befragten als einer der drei wichtigsten Treiber genannt wird, Leistungsoptimierung (35 %), Kostenoptimierung (33 %), erhöhte Agilität (31 %), Risikominderung (30 %) und Zugang zu Best-in-Breed-Lösungen (24 %).

Eine weitere wichtige Sache, die Führungskräfte übernehmen, ist die Notwendigkeit, Daten und Analysen in jedem Teil des Unternehmens zu nutzen, wo sie Wert schaffen können, was im Grunde überall der Fall ist. Um dies zu tun, müssen sie die Datenlieferkette neu gestalten, beginnend bei der Erfassung bis zur Entsorgung. Rund 60 % der Führungskräfte gaben an, dass ihre Unternehmen den Mitarbeiter:innen den erforderlichen Datenzugriff und Analysetools zur Verfügung stellen, im Vergleich zu den anderen 7 % der Befragten.

Nach dieser Umfrage ist erwiesen, dass die Führungskräfte die richtigen Initiativen und Schritte unternehmen, um Daten zu bewerten und in Geschäftswert umzuwandeln.

Anwendungsfälle

Lassen Sie uns nun einige Organisationen betrachten, die ihre unterschiedlichen Daten zusammengeführt und daraus einen großen Erfolg gemacht haben.

Telefónica führt passende Daten zusammen, um die Zufriedenheit zu steigern und das Wachstum voranzutreiben

Telefónica Spanien investiert seit langem in Spitzentechnologien. Mit Millionen von Kund:innen und über 17 Millionen Mobilfunkkund:innen hält das Unternehmen an seinem Engagement für Innovation fest, um seine Kund:innen besser zu verstehen, Dienstleistungen zu personalisieren, Datenkontrolle und -sicherheit zu gewährleisten und die Branchenführerschaft zu behaupten. Telefónica beschloss, sein riesiges Volumen an Kundendaten zu nutzen, indem es diese in einem einzigen Data Warehouse zusammenführte und Echtzeitanalysen anwendete, um den Betrieb und das Kundenerlebnis zu verbessern.

Um die Kundenkontaktpunkte über Marketing, Service und Vertriebsautomatisierung zu verbinden und noch intelligenter zu gestalten, wählte dieses Unternehmen Oracle, um mehr als drei Petabyte an Daten zu speichern, die ständig analysiert werden. Während es zuvor 20 Tage dauerte, eine Zielgruppe für eine CRM-Kampagne zu beschreiben, kann das Unternehmen nun eine bestimmte Zielgruppe in Echtzeit ansprechen. Die Lösung ist auch in der Lage, die TV-Empfehlungs-Engine des Unternehmens zu betreiben, was die Kundenzufriedenheit erhöht und das Geschäftswachstum vorantreibt.

Mehr zum richtigen Umgang mit Kundendaten:

- Der ultimative Leitfaden zur Customer Data Platform (CDP)

- Woran Sie erkennen, ob eine CDP für Ihre Organisation geeignet ist

- CDP vs. CRM

- So wählen Sie die richtige Customer Data Platform

- So implementieren Sie eine CDP erfolgreich

- Wie eine Customer Data Platform die Personalisierung unterstützt

- Der Fall für den Datenschutz von Kundendaten bei der Verwendung von CDP

mStart konsolidiert Daten zur Verbesserung des Einzelhandelserlebnisses und der Effizienz

mStart ist ein kroatischer Anbieter von Geschäfts- und IT-Lösungen für die Landwirtschafts-, Industrie- und Einzelhandelssektoren, der kontinuierlich versucht, Prozesse zu optimieren und die Servicebereitstellung zu verbessern. Das Unternehmen suchte nach umfassenden, detaillierten Einblicken in das Einkaufsverhalten und die Anforderungen globaler Einzelhandelskunden und wollte auch seine Lieferkettenprozesse optimieren. Oracle half mStart beim Aufbau eines Data Lakes, der nahezu in Echtzeit detaillierte Einblicke in die Aktivitäten von über 2.000 Filialen bietet. Die Lösung ermöglicht es Einzelhandelsgeschäften, am selben Tag intelligent Preis- und Aktionsänderungen vorzunehmen, um den Umsatz zu steigern und das Bestandsmanagement zu optimieren. mStart, kombiniert mit Oracle Retail Demand Forecasting und Oracle Retail Replenishment Optimization, ist in der Lage, seine Lieferkettenprozesse zu verbessern und erwartet innerhalb von drei Jahren Transportkosteneinsparungen von 10 Prozent.

Für ein besseres Verständnis können Sie sich diese Frage-Antwort-Runde zwischen Mukesh Jain, Chief Technology & Innovation Officer, Vice President & Head – Insights and Data Technology, Capgemini, und Noah Schwartz, GM, Product and Engineering, AWS Data Exchange, zum Thema Datennutzung zur Förderung von Geschäftswachstum und -wert ansehen.

Datenstrategien zur Steigerung des Geschäftswerts verstehen

Forbes hat drei Strategien vorgestellt, die die Grundlage jeder digitalen Transformationsstrategie bilden sollten.

- Sie müssen eine einzige Sicht auf Ihre Kund:innen aufbauen. Geeignete Daten umfassen Kaufinformationen, Kommunikationspräferenzen, Einkaufsverhalten und Social-Media-Aktivitäten. Dies erfordert die Verbindung von strukturierten Daten (wie Adressen, Haushaltszusammensetzung, sozioökonomische Schicht usw.) mit unstrukturierten Daten (wie dem Freitext eines Twitter-Feeds). Mehr zur Verbesserung des Konsumentenverhaltens mit einer perfekten datengesteuerten Strategie finden Sie hier.

- Sie müssen die Standortdaten nutzen, um Präzision und Kontext hinzuzufügen. In dieser hochentwickelten Welt müssen Sie nicht alles über Ihre Kund:innen wissen. Alles, was Sie wissen müssen, ist ihr Standort, um ein wirklich hyper-personalisiertes und reaktionsschnelles Erlebnis zu bieten.

- Sie müssen die passende Kommunikation zur richtigen Zeit über den richtigen Kanal erstellen. Da Daten signifikante Details über Kund:innen anzeigen, ist es wirklich notwendig, sie über verschiedene Gesprächspunkte hinweg ansprechen zu können.

Das Nächste, was Sie wissen sollten, ist, dass die Datenstrategie eng mit den Geschäftsergebnissen abgestimmt sein muss. Doch zuvor sollten Sie unbedingt wissen, was Datenstrategien sind und wie Sie eine Datenstrategie entwickeln. Nur dann können Sie einen zusätzlichen Vorteil erzielen, indem Sie eine erfolgreiche Datenstrategie planen. Viele der Geschäftsergebnisse werden unter den folgenden Kategorien klassifiziert.

Ihre Mitarbeiter:innen stärken

Ermöglichen Sie Ihren Mitarbeiter:innen den Echtzeit-Zugriff auf Informationen über Kund:innen, Geräte und Maschinen, um effizient zusammenzuarbeiten und Kunden- oder Geschäftsanforderungen agil zu erfüllen.

Kundenbindung

Sie können Ihren Kund:innen ein personalisiertes, reichhaltiges und vernetztes Erlebnis bieten. Durch die Nutzung der Kraft von Daten und Erkenntnissen können Sie die Loyalität entlang jeder Phase der Customer Journey fördern.

Abläufe optimieren

Sie müssen den Informationsfluss über Ihren gesamten Geschäftsbetrieb hinweg erhöhen. Es ist erforderlich, Ihre Geschäftsprozesse synchron zu halten und jede Interaktion durch einen datengesteuerten Ansatz sinnvoll zu gestalten.

Ihre Produkte und den Entwicklungslebenszyklus transformieren

Sie müssen Telemetriedaten über Ihre Dienste und Angebote sammeln. Sie können die Daten weiter nutzen, um eine Veröffentlichung zu priorisieren oder eine neue Funktion zu erstellen und die Wirksamkeit und Akzeptanz ständig zu bewerten.

Schließlich werfen wir nun einen Blick auf die Strategien, die Ihren Geschäftswert in großem Maßstab steigern können.

Die grundlegende Annahme in Frage stellen, die die Experimentierfreiheit einschränkt

Eine der wichtigsten Herausforderungen, denen sich Unternehmen gegenübersehen, ist der mangelnde Zugang zu zentralisierten Daten, um daraus einen Wert zu ziehen. Aufgrund dieser Schwierigkeit sind Unternehmen nicht in der Lage, datengesteuerte Experimente durchzuführen, um bessere Geschäftsergebnisse zu erzielen.

Da sich Daten ständig ändern und Sie möchten, dass sie sich ändern, und Sie neue Kund:innen und Märkte gewinnen möchten, müssen Sie eine Struktur aufbauen, die auf Veränderungen reagiert und anpassungsfähig ist. Um von der bloßen Verfügbarkeit von Daten zur Nutzung als Grundlage für Produkte, Personalisierung und ein nahtloses Kundenerlebnis zu gelangen, benötigen Sie Experimentierfreiheit. Eine monolithische Datenarchitektur macht diese Aufgabe monumental, indem sie die Kluft zwischen Theorie und Praxis vergrößert. Es gibt auch einen Tooling-Aspekt, der die Zykluszeit für Entscheidungen beeinflussen kann.

Organisationen sollten einen agilen Ansatz für das Datenmanagement priorisieren

Organisationen müssen einen agilen Ansatz für Daten verfolgen und diese näher an die relevanten Geschäftsbereiche heranführen. Dies kann durch die Anwendung von zwei Hauptprinzipien erreicht werden: domänenorientierte Daten und Daten als Produkt. Domänenorientiertes Eigentum und Verteilung helfen dabei, die Datenarchitektur um einzelne Funktionen herum aufzubrechen, während gleichzeitig eine umfassende Konnektivität und Integrität aufrechterhalten wird. Die Nutzung von Daten als Produkt anstelle einer Ressource wird dann einfach zu konsumieren und zu nutzen. Diese Praktiken sind die Grundlagen einer Datenarchitektur, die für ein widerstandsfähiges, schnell agierendes, digitales Geschäft gut konzipiert ist: Data Mesh.

Data Mesh betrachtet die Grundursache der Unfähigkeit, Daten in großem Maßstab zu nutzen, und versucht, diese anzugehen.

Entwurf einer modernen Plattformarchitektur

Es wird beobachtet, dass Self-Service-Plattformen dabei helfen, Daten so zu positionieren, dass sie sofort genutzt werden können, anstatt sie zu speichern und erst nach weiteren Prozeduren zugänglich zu machen. Darüber hinaus ermöglichen moderne Plattformarchitekturen, Daten näher zu kommen und Erkenntnisse frühzeitig zu gewinnen, wodurch das Chaos, das mit Data Engineering einhergeht, vermieden wird. Diese Architekturen erweisen sich als perfekte Wegbereiter für Unternehmen, die ihre jeweiligen Teams so positionieren, dass sie Zugang zu standardisierten Datenfunktionen erhalten, die weiter zu verschiedenen Produkten zusammengestellt werden können. Beim Aufbau einer Datenplattform werden Unternehmen nicht immer bei Null anfangen. Die aktuellen Cloud-Technologien können als Utility-Layer fungieren, der Speicher- und Streaming-Funktionen sowie Standards bereitstellt, auf denen reifere Schichten der Plattform aufgebaut werden können, um die Kommunikation mit verteilten Architekturen und auch dezentralen Teams zu unterstützen.

Ihre Mitarbeiter:innen von den Strategien überzeugen

Auch wenn Datenarchitektur kompliziert sein kann, müssen Sie, um datengesteuerter zu werden, Menschen und Kultur priorisieren, anstatt sich auf Technologie oder Engineering zu konzentrieren. Prasanna Pendse, Head of Technology, India, bei Thoughtworks, sagt: „Die Wahrheit ist, dass Menschen Daten und insbesondere Data Governance betrachten und ihre allgemeine Reaktion ein Stöhnen ist. Es wird als langweilig angesehen, etwas, das sie verwalten müssen, eine Last. Führungskräfte mögen daran glauben, aber sie können ihre Teams nicht überzeugen. Diese Wahrnehmungen müssen sich ändern, damit die Menschen interessiert sind, Daten nutzen und konsumieren wollen und von den Möglichkeiten begeistert sind.“ Um diese Situation zu verbessern, benötigen Sie zuallererst eine klare und umfassende Datenstrategie. Was ist also der Wert einer Datenstrategie? Sie muss durch eine Kultur der Evangelisierung dessen entstehen, was Daten genau bedeuten und warum sie für das Unternehmen wichtig sind, sei es zur Schaffung weiterer Erkenntnisse, zur Entwicklung weiterer Produkte, aus regulatorischen Gründen oder zur Prozesskontrolle. Egal, ob es von der C-Level-Ebene kommt, es muss von allen Führungskräften im Unternehmen angenommen werden. Auch die Beschreibung des strategischen Zwecks von Daten hilft bei der Entscheidung, welche Daten und zugehörigen Lösungen priorisiert werden sollen.

Es ist nicht verkehrt, klein anzufangen und stets bereit zu sein, aus den Erfahrungen zu lernen. Sie benötigen Feedback-Zyklen, die Ihnen helfen, zu erkennen, was wirklich für Sie funktioniert und was genau angepasst werden muss. Den Teams soll die Befugnis gegeben werden, Dinge zu entwickeln und die erforderlichen Änderungen vorzunehmen. Indem Sie die richtigen Leute finden, können Sie ihnen die notwendige Zeit und den Raum für die Änderungen geben.

Umgang mit dem Mangel an Datentalenten

In Unternehmen stellen wir manchmal fest, dass ausreichend Datentalent vorhanden ist, die Menschen es aber nicht erkennen. Zum Beispiel könnten einige Menschen Interesse an Daten haben, aber sie sind daran gehindert, mit Systemen zu kommunizieren oder sogar mit Entwickler:innen zusammenzuarbeiten, da solche Aufgaben nicht zu ihrer formalen Rolle gehören. In dieser Situation kann das Konzept des „Data Mesh“ wirklich hilfreich sein. Es geht darum, Verantwortlichkeiten stärker auf die Domänenteams zu übertragen, den Menschen die Nutzung von Sandbox-Umgebungen zu ermöglichen und ihnen vollen Zugang zu gewähren. Sie müssen den Menschen lediglich erlauben, mehr Erfahrung mit Datensystemen zu sammeln, ihre Angst zu reduzieren und nicht zu streng mit ihnen zu sein. Es ist auch vorzuziehen, vorhandene Talente umzuschulen oder weiterzubilden, da sie einen höheren Return on Investment bieten können als die Einstellung neuer Datenspezialist:innen.

Fazit

Aus diesem Artikel geht hoffentlich klar hervor, dass Unternehmen bestrebt sind, vollständig datengesteuert zu werden, um bessere Geschäftsergebnisse und Erfolge zu erzielen. Sie nutzen verschiedene Plattformen, um riesige Datenmengen zu analysieren und diese zur Entwicklung von Wettbewerbsvorteilen einzusetzen. Manchmal kann dies eine herausfordernde Aufgabe sein, aber die Unternehmensführer:innen sind fest entschlossen, die notwendigen Maßnahmen zu ergreifen, um ihren Kund:innen exzellente Dienstleistungen zu bieten und ihre Geschäftseffizienz zu steigern.

Abonnieren

Verwandte Blogs

Trek n Tech Jahres-Retreat 2025: Eine 7-tägige Workcation von OSL

Die OSL-Familie kam vom 7. bis 13. Dezember 2025 zum jährlichen Trek n Tech Retreat 2025 zusammen, einer 7-tägigen…

Erkunden von Drupal Single Directory Components: Ein Wendepunkt für Entwickler

Webentwicklung lebt von Effizienz und Organisation, und Drupal, unser Lieblings-CMS, ist mit seiner neuesten Funktion hier,…

7 schnelle Schritte zur Erstellung von API-Dokumentationen mit Postman

Wenn Sie mit APIs arbeiten, kennen Sie wahrscheinlich bereits Postman, den beliebten REST Client, dem unzählige Entwickler…