Sprachassistenten wie Siri, Alexa und Google bergen ein immenses Potenzial in ihren Technologien. Sie können Menschen mit Behinderungen in ihrem täglichen Leben helfen und werden einen großen, großen Einfluss auf ihre jeweiligen täglichen Aufgaben und ihren üblichen Lebensstil haben. Auf der anderen Seite.

Sprachassistenten schaffen eine völlig neue und andere Technologie- und Marktplatzlandschaft sowie Ökosysteme um sie herum. Zweifellos werden wir in wenigen Jahren die Zukunft erleben, von der wir immer geträumt haben.

VUI ist der neue Trend

Voice User Interfaces (VUI) - Sprachbenutzerschnittstellen (VUI) sind die primären oder ergänzenden visuellen, auditiven und taktilen Schnittstellen, die die Sprachinteraktion zwischen Menschen und Geräten ermöglichen.

VUI bringt einige Herausforderungen für die Designer mit sich:

- Einige Benutzer sind sich nicht bewusst, was sie den Sprachassistenten fragen können und was nicht.

- Die Antwort dauert nicht lange. Es ist eine Sache von Sekunden, sie befindet sich nur im Kurzzeitgedächtnis des Benutzers und hat keine Persistenz.

Über Prompts & Statements: Die Sprache von VUI

Nachdem ein Aktivierungssatz wie "Hey Siri" oder "Hey Google" oder "Hey Alexa" gehört wurde, wacht das Gerät oder VUI aus einer Art Schlaf- oder Ruhezustand auf und antwortet innerhalb von Sekundenbruchteilen; und das auch noch in einer TTS-Ausgabe - Text To Speech.

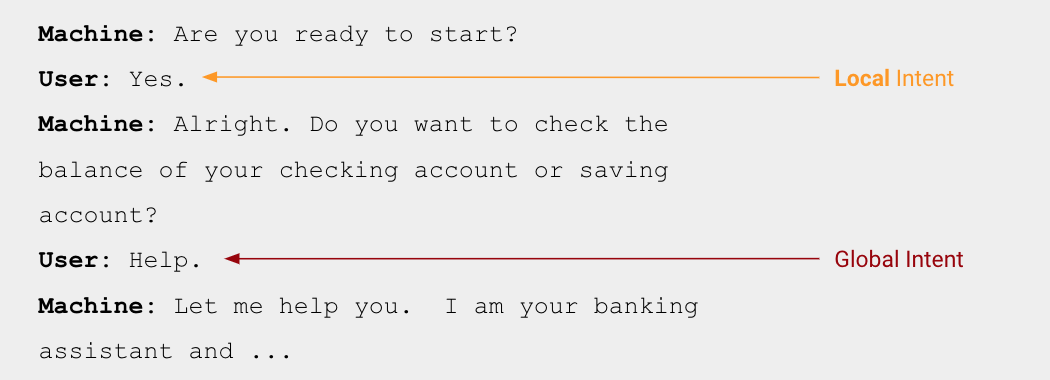

Im Fall von Entwicklern unterscheidet sich die VUI-Ausgabe nicht wesentlich. Sie müssen sich mit den Variationen einer Ausgabe auseinandersetzen. Während die Designer von Voice User Interfaces klar zwischen einem Prompt und einem Statement unterscheiden müssen.

Im Allgemeinen bilden Prompts und Statements die Kernbausteine jeder menschlichen Konversation. Wenn Sie an der Reihe sind zu sprechen, werden Sie wahrscheinlich eine Aussage machen, gefolgt von einer Aufforderung, Ihren Gesprächspartner wieder in das Gespräch einzubeziehen, und sei es nur, um zu bestätigen, dass er Sie gehört hat.

Prompts stellen Fragen an die andere Partei und suchen nach einer Antwort; sie nehmen viele Formen an: von offenen Fragen ("Was denkst du?"), geschlossenen Fragen ("Bist du bereit?") bis hin zu Intonation, Körpersprache oder Blickkontakt, die die andere Person einladen, in das Gespräch einzusteigen.

Statements geben eine Meinung, einen Kommentar oder Informationen wieder und fordern keine Eingaben an; das Unterbrechen eines Statements würde in den meisten sozialen Situationen als unhöflich gelten. VUI-Designer müssen zwischen Prompts und Statements unterscheiden, da jedes eine eigene Authoring-Strategie erfordert.

Wie zugänglich sind Heimassistenten?

Das Konzept der Voice User Interfaces (VUI) wirkt sehr durchdacht. Sehr geübt und darauf ausgerichtet, die Welt zu einem besseren Ort zu machen, kein Witz, diese Worte haben viel Gewicht. Was machen Sprachassistenten?

- Einige Leute haben Probleme mit der Bedienung von Mobilgeräten, und es ist für sie äußerst angenehm, dass sie nicht mit Bildschirmen und Beleuchtung und Blah Blah herumspielen müssen. Sie neigen dazu, keine Frustration, kein Unbehagen oder starke Kopfschmerzen oder Schwierigkeiten bei der Ausführung ihrer Befehle mit ihrer Stimme zu verspüren.

- Einige Leute haben große Schwierigkeiten, die auf ihren Bildschirmen angezeigten Wörter zu lesen und zu verstehen, aber sie finden es einfach, wenn sie die gleichen Informationen hören können, und es können Leute sein, denen das Lesen schwerfällt, Informationen hören, anstatt sich mit dem textlastigen Internet herumzuschlagen.

- Menschen mit eingeschränkter oder keiner Sehfähigkeit finden es möglicherweise schneller, eine Sprachschnittstelle zu verwenden, als eine Website mit einer Lupe oder einem Screenreader.

- Einige Menschen mit kognitiven Problemen oder die von Computerschnittstellen überfordert sind, finden eine Sprachschnittstelle möglicherweise einfacher zu bedienen als eine große Website.

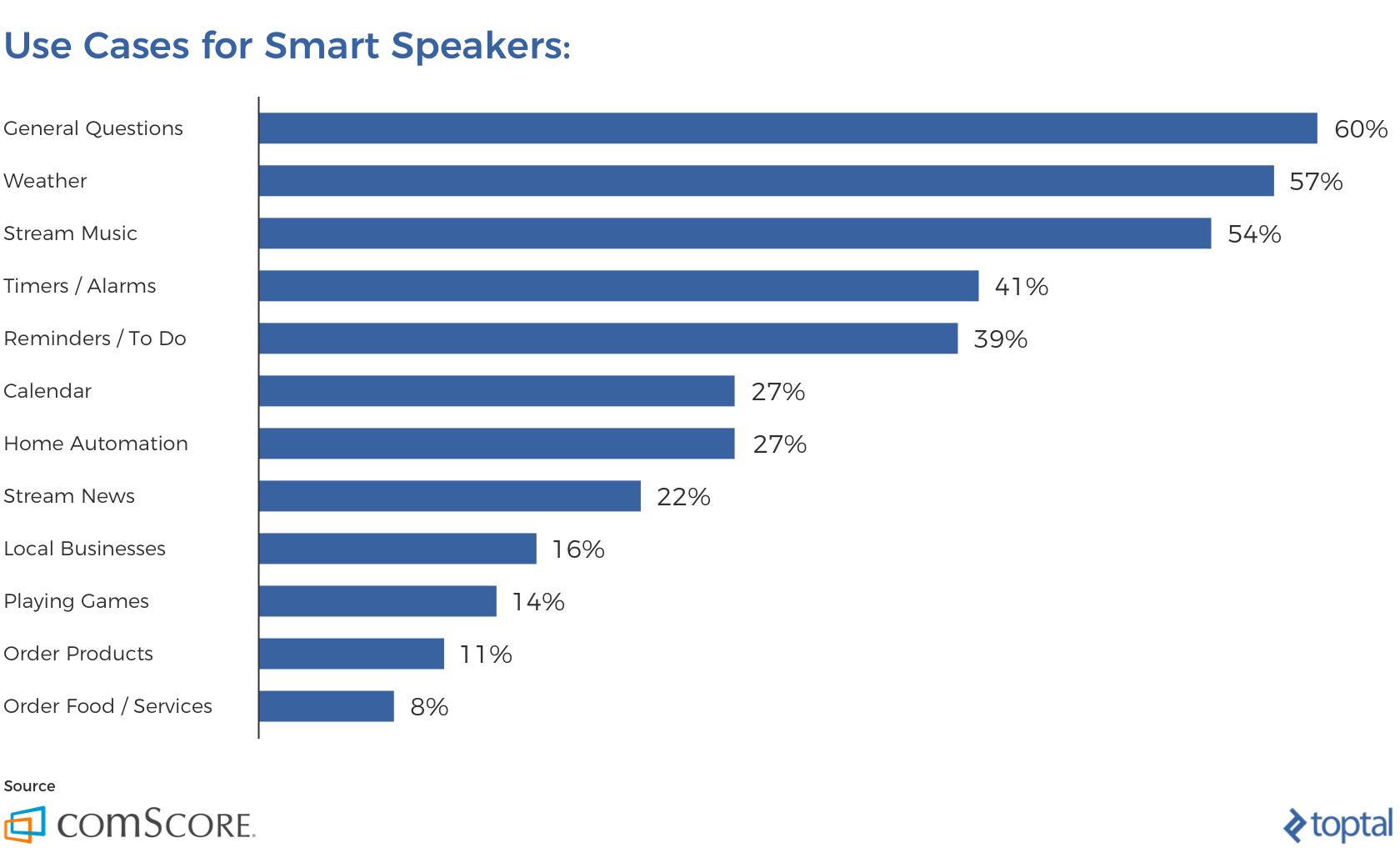

Hier sind einige Nutzungsstatistiken für intelligente Lautsprecher und warum sie einen großen Beitrag zur Barrierefreiheit leisten:

Google Assistant ist in seiner Kategorie viel ausgereifter - "Google Assistant eröffnet viele neue Wege"

Eine Person verlor ihre Fähigkeit zu sprechen, aber mit der Speak-Selection-Funktion von Siri konnte sie immer noch ihre regulären E-Mails lesen oder sich über Artikel informieren, aber eines konnte sie nicht mehr tun: Siri mit ihrer Stimme über den Befehl "Hey, Siri" auslösen, um das zu tun, was die Welt im Bruchteil einer Sekunde und mit äußerster Leichtigkeit tat.

Später wurde dann der Google Assistant mit seinem sehr marktreifen Namen und einer ganz neuen Art der Interaktion mit Sprachassistenten eingeführt, wobei Text- und Sprachbefehle verwendet wurden. Dann kam Google Assistant mit seinem unkreativen Namen und einer ganz neuen Option, entweder Sprach- oder Textbefehle zu verwenden. Das machte vieles für die Leute einfacher. Er konnte Termine vereinbaren und seinen Kalender zur Verfügung haben.

Amazon Alexa ist in meinen Fällen zu einem Familienmitglied geworden

Die Leute nutzen Alexa für viele Familienzwecke. Es gilt als der am besten eingeführte Heimassistent mit einem vergleichsweise erschwinglichen Preis und macht das Leben vergleichsweise einfacher. Das soll nicht heißen, dass sie perfekt in ihrer Kategorie sind, aber sie erhalten mit der Zeit ihre verdiente Ausbildung und sollen von hier an nur noch besser werden.

Spracherkennung und Text-to-Speech

Apps helfen Menschen mit Sprachfehlern und solchen, die sich von Schlaganfällen und Hirnverletzungen verschiedener Art erholen, oder solchen, die unter verschiedenen Arten von Sprachunfähigkeit leiden. Die Apps lernen im Laufe der Zeit ihr jeweiliges Aussprachemuster und gleichen es mit ihrem eigenen Vokabular ab. Sie lernt die Aussprache der Sprecher im Laufe der Zeit und normalisiert Anomalien in exportierbaren Audio- und Textdateien.

In der Zwischenzeit verwendet die Deep Mind-Abteilung von Google KI, um Untertitel für gehörlose Benutzer zu erstellen. Laut einer gemeinsamen Studie aus dem Jahr 2016, die von einem Expertenteam der Universität Oxford durchgeführt wurde, sah sich der Algorithmus von DeepMind mehr als 5.000 Stunden Fernsehen an und analysierte 17.500 einzigartige Wörter. Das resultierende Modell übertraf einen professionellen Lippenleser deutlich und übersetzte 46,8 Prozent der Wörter in 200 zufällig ausgewählten Clips fehlerfrei im Vergleich zu den 12,4 Prozent der Wörter des menschlichen Profis.

Ein abschließender Hinweis

Das Potenzial von Sprachassistenten ist tadellos und kann ein Ausmaß erreichen, in dem Menschen mit Behinderungen ihre täglichen Aufgaben ohne die besonderen Mühen bei der Ausführung erledigen können. Ich bin auf jeden Fall gespannt auf das, was noch kommt und was bisher erreicht wurde. Barrierefreiheit wird zur obersten Priorität der Technologie und es wird Zeit brauchen, dies zu erreichen.

Abonnieren

Verwandte Blogs

Trek n Tech Jahres-Retreat 2025: Eine 7-tägige Workcation von OSL

Die OSL-Familie kam vom 7. bis 13. Dezember 2025 zum jährlichen Trek n Tech Retreat 2025 zusammen, einer 7-tägigen…

Erkunden von Drupal Single Directory Components: Ein Wendepunkt für Entwickler

Webentwicklung lebt von Effizienz und Organisation, und Drupal, unser Lieblings-CMS, ist mit seiner neuesten Funktion hier,…

7 schnelle Schritte zur Erstellung von API-Dokumentationen mit Postman

Wenn Sie mit APIs arbeiten, kennen Sie wahrscheinlich bereits Postman, den beliebten REST Client, dem unzählige Entwickler…