Kubernetes erobert den Cloud-Bereich in rasantem Tempo und entwickelt sich zum Betriebssystem für die Cloud. Die Weitläufigkeit von Kubernetes hat Entwicklern und Unternehmen viele große Vorteile gebracht. Im Jahr 2017 entstanden viele native Kubernetes-Dienstleister und die Wiederherstellung vieler anderer Container-Orchestrierungsplattformen, die eine solide Grundlage für die Cloud-Dienstleister bilden. Der umfassende Aufstieg in der Manifestation von Kubernetes sichert eine sehr rosige Zukunft.

Lassen Sie uns eintauchen, um zu erfahren, warum Kubernetes im Trend liegt und welche Qualität es besitzt, die das Interesse der Menschen weckt.

Was ist Kubernetes?

Kubernetes wurde 2014 von Google entwickelt und ist ein Open-Source-Projekt, dessen zentraler Punkt der Aufbau einer robusten Anordnung von Systemen ist, um Tausende von Containern in der Produktion zu betreiben.

Der Begriff wurde von dem griechischen Wort "κυβερνήτης" abgeleitet, was "Steuermann" oder "Pilot" bedeutet, mit einer ersten Veröffentlichung im Jahr 2014. Google als ursprünglicher Autor machte das Kubernetes-Projekt Open Source.

Kubernetes vereint die branchenführenden Ideen und Ansätze der Google-Community und kann als portable und flexible Plattform für die Verwaltung von containerisierten Workloads und Diensten definiert werden. Es ermöglicht sowohl die deklarative Konfiguration, Skalierung als auch die Automatisierung der containerisierten Anwendungen. Es nimmt die logische Gruppierung der Container für eine reibungslose Verwaltung und Erkennung vor. Das komplette Regime von Kubernetes besteht aus Tools, Diensten und Supportsystemen, die umfassend verfügbar sind.

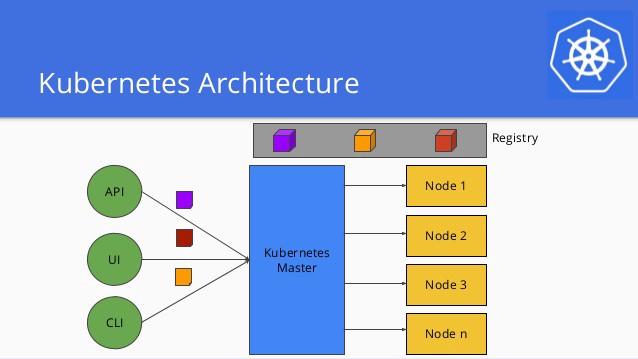

Kubernetes-Architektur

Ähnlich wie bei vielen verteilten Computerplattformen sind die folgenden die Komponenten eines Kubernetes-Clusters.

Der Master-Knoten (mindestens einer) verwaltet den gesamten Kubernetes-Cluster, stellt die Application Programming Interface (API) bereit und plant die gesamte Bereitstellung.

Knoten (Worker-Knoten) umfassen virtuelle Maschinen (VMs), die über die Cloud laufen, oder freiliegende Metallserver, die in einem Rechenzentrum laufen. Er verbindet sich zusammen mit einem Agenten mit dem Master und führt die Container-Laufzeitumgebung aus (Docker oder rkt). Darüber hinaus sind Protokollierung, Überwachung, Service Discovery und optionale Add-ons einige zusätzliche Bestandteile des Knotens. Knoten, die die Worker des Kubernetes-Clusters sind, berechnen, vernetzen und speichern Ressourcen für die Anwendungen.

Jeder Container unterscheidet sich von jedem anderen Container. Zum Beispiel kann einer eine Web-App sein und der andere für die konsistente Datenspeicherung verwendet werden. Kubernetes vereinfacht den Prozess, einen Container auszuführen, und erleichtert parallel dazu den Prozess, verschiedene Arten von Containern nebeneinander auszuführen. Die Fähigkeit von Containern, die Tatsache zu verstehen, dass es beim Betreiben eines Systems nicht nur um das Betreiben eines Containers geht, hebt es von den anderen Orchestrierungssystemen ab.

Ist es überhaupt möglich, eine Anwendung mit vielen beweglichen Teilen zu entwerfen und gleichzeitig die Orchestrierung und Bereitstellung reibungslos zu gestalten? Wie kann man die gleichmäßige Verteilung einer Last bestimmen? Wie kann die Speicherung mit mehreren Instanzen konsistent gehalten werden? sind einige der regelmäßigen Fragen, die von Kubernetes beantwortet wurden.

Traditionelle Bereitstellung zu Kubernetes - Evolution

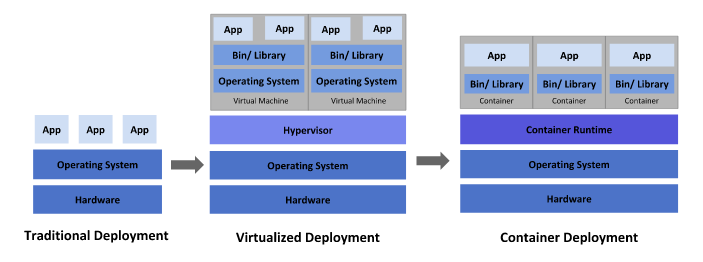

Traditioneller Bereitstellungszyklus

Die traditionelle Bereitstellungsära umfasste die Anwendungen, die auf physischen Servern liefen. Da es keinen Prozess zur Zuweisung von Ressourcen gab, verursachte dies viele Probleme bei der Ressourcenzuweisung. Es gab viele Fälle, in denen eine Anwendung die meisten Ressourcen beanspruchte, was zu einer Minderleistung der anderen Anwendungen führte.

Das Ausführen von Anwendungen auf verschiedenen physischen Servern wurde als Lösung für das oben genannte Problem empfohlen. Dies führte zu einer Unterauslastung der Ressourcen, was es für die Unternehmen teuer machte, die physischen Server zu warten.

Virtualisierter Bereitstellungszyklus

Mit dem Ziel, eine Lösung für die Probleme zu bieten, die bei den traditionellen physischen Servern auftraten, wurde das Virtualisierungskonzept eingeführt. Eine virtuelle Maschine ist ein komplettes System, das ein eigenes Betriebssystem auf der virtualisierten Hardware umfasst. Die Virtualisierung bringt eine bessere Auslastung der Ressourcen in physischen Servern.

In der Virtualisierung sind Anwendungen zwischen den virtuellen Maschinen isoliert, wodurch sie sicher bleiben. Dies verhindert, dass die Informationen einer Anwendung leicht von der anderen Anwendung abgerufen werden können. Außerdem kann eine Anwendung einfach hinzugefügt oder aktualisiert werden, was die Kosten für die Hardware reduziert.

Container-Bereitstellungszyklus

Nicht sehr unterschiedlich zu virtuellen Maschinen ist die Isolation in Containern etwas entspannter, da sich Anwendungen Betriebssysteme teilen. Container sind leichtgewichtig und bestehen aus einem eigenen Dateisystem, CPU, Speicher usw. Außerdem können sie leicht über die Cloud- und Betriebssystemverteilungen portiert werden. Kontinuierliche Integration und Bereitstellung, Erstellung und Bereitstellung von agilen Anwendungen, hohe Effizienz und Dichte aufgrund der Ressourcenauslastung sind einige der Vorteile, die Unternehmen durch die Umstellung auf einen Container-Bereitstellungszyklus erzielen.

Gründe, warum Kubernetes im Trend liegt

Die folgenden Gründe erklären, warum sich die Leute für Kubernetes gegenüber allem anderen entscheiden.

- Instrumentierung der Speicherung: Kubernetes automatisiert für einen Benutzer die Auswahl eines Speichersystems aus lokalem Speicher, öffentlichen Cloud-Anbietern und vielen anderen mehr.

- Lastausgleich und Service Discovery: Wenn der Container stark frequentiert ist, gleicht Kubernetes die Last aus und verteilt den Netzwerkverkehr für die stabile Bereitstellung der Anwendung. Darüber hinaus deckt Kubernetes einen Container mit einem DNS-Namen oder mit seiner eigenen IP-Adresse auf.

- Angemessenes Ressourcenmanagement: CPU und RAM für die Container können mit Hilfe von Kubernetes festgelegt werden. Wenn bestimmte Ressourcenanforderungen eingehen, erstellt Kubernetes eine bessere Zuweisung und Verwaltung der Ressourcen für Container.

- Automatisierte Verteilung und Rollbacks: Wenn der gewünschte Zustand für einen bereitgestellten Container mit Kubernetes beschrieben wird, ändert er sich mit einer sehr kontrollierten Geschwindigkeit vom tatsächlichen in den gewünschten Zustand. Zum Beispiel kann der Austausch alter Container durch neue mit Kubernetes automatisiert werden.

- Selbstwiederherstellung: Wenn ein Container ausfällt, startet Kubernetes ihn neu, ersetzt den Container, beendet den, der nicht auf die benutzerspezifische Gesundheitsprüfung reagiert, und befördert sie nicht zu Clients, bis sie bereit sind, zu dienen.

- Geheimnis- und Konfigurationsmanagement: Sensible Informationen wie Passwörter, OAuth-Token und SSH-Schlüssel werden von Kubernetes bereitwillig gespeichert und verwaltet. Bereitstellung und Aktualisierungen von Geheimnissen und Anwendungskonfigurationen können durchgeführt werden, ohne Ihre Container-Images neu zu erstellen und ohne Geheimnisse der Stack-Konfiguration preiszugeben.

Veränderung der Entwicklungs- und Infrastrukturlandschaft mit Kubernetes

Kubernetes-Handling-Systeme

Wie bereits erwähnt, besteht Kubernetes aus zwei Arten von Knoten, nämlich einem Master und einem Worker. Die folgenden Aufzählungszeichen behandeln das Arbeitsmodell zusammen mit den anderen Unterteilen von Kubernetes in Systemen.

- Pod: Die Sammlung von Containern oder eine Arbeitskomponente, die auf demselben Host bereitgestellt wird, ist die Definition von Pods. Pods erleichtern den Prozess der Servicesuche mit Kubernetes Service Discovery, da sie aus ihren eigenen IP-Adressen bestehen. Einzelne oder eng gekoppelte mehrere Container oder Services laufen innerhalb desselben Pods. Kubernetes verbindet und verwaltet den Pod in der Anwendungsumgebung, wie z. B. das Abwickeln der Bereitstellungen, die Überwachung usw.

- Replikations-Controller: Die Wartung der von einem Benutzer angeforderten Pods erfolgt über einen Replikations-Controller. Er gewährleistet eine einfache Skalierung der Anwendung. Der Prozess läuft wie folgt ab: Wenn ein Container ausfällt, startet der Replikations-Container einen anderen Container, wodurch die ausreichende Anzahl von Replikat-Pods gewährleistet wird.

- Service: Eine einzelne Entität, die aus der Gruppierung logischer Sammlungen von Pods gebildet wird, um dieselbe Funktion auszuführen. Knoten eines Clusters werden bei der Erstellung eines neuen Services benachrichtigt. Die Verteilung von Services rationalisiert das Container-Design und gewährleistet eine einfache Container-Erkennung. Die Single-Point-Zugänglichkeit macht die Kommunikation zwischen der Sammlung von Pods mühelos.

- Label: Labels sind für das ordnungsgemäße Funktionieren von Services und Replikations-Controllern unerlässlich. Dies sind die Metadaten-Tags für die einfache Suche nach Kubernetes-Ressourcen, die über ein Label erfolgt. In Anbetracht der Tatsache, dass der Host von Kubernetes auf die Abfrage der Cluster zur Suche nach Ressourcen angewiesen ist, macht eine abfragebasierte Suche aufgrund von Labels es für die Entwickler mühelos.

- Volume: Der Ort, an dem die Container auf die von Ceph, lokalem Speicher, elastischem Block Storage usw. unterstützten Informationen zugreifen und diese speichern, wird als Volume definiert. Für eine Anwendung ist das Volume ein Abschnitt eines lokalen Dateisystems.

- Namespace: Das Clustering innerhalb eines Kubernetes erfolgt über Namespaces. Die Zusammenarbeit von Services, Pods, Replikations-Controllern und Volumes erfolgt einfach unter einem Namespace. Darüber hinaus bietet es eine kleine Isolation von anderen Teilen des Containers.

Entwicklung auf und mit Kubernetes

Mit dem Ziel, eine bessere Erfahrung für Entwickler zu gewährleisten, arbeiten das Kubernetes-Team und die Community prägnant daran, das Community-Engagement und die ordnungsgemäße Dokumentation für einen Neuling zu stärken. Der Geist ist, das Lernen und die Einführung von Kubernetes zu rationalisieren und schmerzlos zu gestalten. Die folgenden Aufzählungszeichen unterstützen, wie Kubernetes die Arbeit für die Entwickler tatsächlich rationalisiert.

Minikube, eine virtuelle Maschine, die Docker und Kubernetes ausführt, wird verwendet, um kleine, in sich geschlossene Cluster auf lokalen Maschinen (macOS, Linux, Windows) zu erstellen. Die Bereitstellung in Minikube kann wie jedes andere Kubernetes erfolgen. Minkubes mit lokalem Kubernetes, das sich auf Docker befindet, ahmt den Bereitstellungs- und Produktionsworkflow näher als je zuvor nach. Docker-Images, die für die Ausführung in einer Umgebung entwickelt wurden, können einfach lokal mit einem Minikube ohne Änderung ausgeführt werden. Tools wie Draft von Azure lösen viele Herausforderungen von einem System lokal. Somit bildet sich damit ein komplettes lokales Entwicklungs-Inter-Netzwerk. Kubernetes wurde jetzt von Docker in seinem Pack hinzugefügt.

Sobald das gesamte Bereitstellungs-Setup verstanden ist, kommt nun die Anwendung der kontinuierlichen Bereitstellung auf den Kubernetes-Workflow, wobei die unveränderten Releases, keine Brüche und eine erhöhte Wiederverwendbarkeit und Ähnlichkeitswartung zwischen den Umgebungen intakt bleiben. Helm ist ein Tool zur Verwaltung von Kubernetes-Charts und ein Repository für die vorkonfigurierten Kubernetes-Ressourcen. Es kann verwendet werden, um Kubernetes als wiederverwendbaren Vorlagencode über Umgebungen hinweg auszudrücken, indem die Variablenänderungen zum Zeitpunkt der Bereitstellung durchgeführt werden. Helm-Charts werden auch für verschiedene gängige Open-Source-Anwendungen wie Grafana, InfluxDB, Concourse usw. bevorzugt.

Kubernetes & Cloud-Infrastruktur-Ökosystem

In einer Cloud-Infrastrukturumgebung fungiert Kubernetes als unentschlossene Schicht zwischen der Cloud-Plattform und den Anwendungen. Dies verbindet Cluster über mehrere Cloud-Anbieter hinweg und verspricht die Ausführung von Kubernetes auf Bare-Metal-Servern und eine verbesserte Erreichbarkeit. Kubernetes ermöglicht sowohl eine kompakte Integration als auch Unabhängigkeit für die Cloud-Anbieter. Nehmen wir zum Beispiel an, eine Anwendung benötigt einen Load Balancer. Wenn man mit einem herkömmlichen Ansatz vorgeht, wird die Anwendung zunächst erstellt und verpackt. Später wird mit Terraform-Vorlagen oder CloudFormation-Bereitstellungsumgebung die Anforderung für einen AWS Elastic Load Balancer beschrieben.

Wenn man mit Kubernetes fortfährt, wird der Load Balancer in seinem Manifest angegeben, aber nicht unbedingt der AWS Elastic Load Balancer. Kubernetes rendert die Anforderung für einen Load Balancer auf der Grundlage des Cloud-Anbieters, in dem der Cluster bereitgestellt wird. Daher wird, wenn ein Cluster in AWS ist, ein AWS Elastic Load Balancer bereitgestellt und automatisch mit der Cloud verbunden, wobei die Bereitstellungskonfiguration integral gehalten wird. Im Gegenteil, der GCP Load Balancer wird für die Google Cloud bereitgestellt. Ein ähnliches Muster wird für externe DNS-Einträge, dauerhafte und stabile Speichervolumes befolgt.

Wenn wir mit der Cloud fortfahren, sind Kubeless und Fission die Tools, die in einer serverlosen Welt ähnlich wie Functions-as-a-Service laufen und die starke Grundlage von Kubernetes in der serverlosen Welt anzeigen. Wohin steuern wir, ist die Zukunft Serverless?

Fazit

Kubernetes entwickelt sich schnell zum De-facto-Orchestrierungstool für die deklarative Verwaltung offener Infrastrukturen und wächst immer noch rasant. Container breiten ihre Flügel in der Softwareentwicklungsarena aus. Kubernetes, das die Leistungsfähigkeit der Infrastruktur durch die Beibehaltung aller beweglichen Teile und Abhängigkeiten bringt, wird das kontinuierliche Wachstum über verschiedene Infrastrukturen hinweg fördern und sie weniger komplex halten.

Die nächsten Jahre werden definitiv viel mehr Fortschritte in Kubernetes sehen und wir werden viel mehr aufregende Technologien sehen, die über Kubernetes aufgebaut werden und es Unternehmen ermöglichen, viele wichtige Vorteile daraus zu ziehen. Die Zukunft ist in der Tat rosig.

Abonnieren

Verwandte Blogs

Trek n Tech Jahres-Retreat 2025: Eine 7-tägige Workcation von OSL

Die OSL-Familie kam vom 7. bis 13. Dezember 2025 zum jährlichen Trek n Tech Retreat 2025 zusammen, einer 7-tägigen…

Erkunden von Drupal Single Directory Components: Ein Wendepunkt für Entwickler

Webentwicklung lebt von Effizienz und Organisation, und Drupal, unser Lieblings-CMS, ist mit seiner neuesten Funktion hier,…

7 schnelle Schritte zur Erstellung von API-Dokumentationen mit Postman

Wenn Sie mit APIs arbeiten, kennen Sie wahrscheinlich bereits Postman, den beliebten REST Client, dem unzählige Entwickler…